|

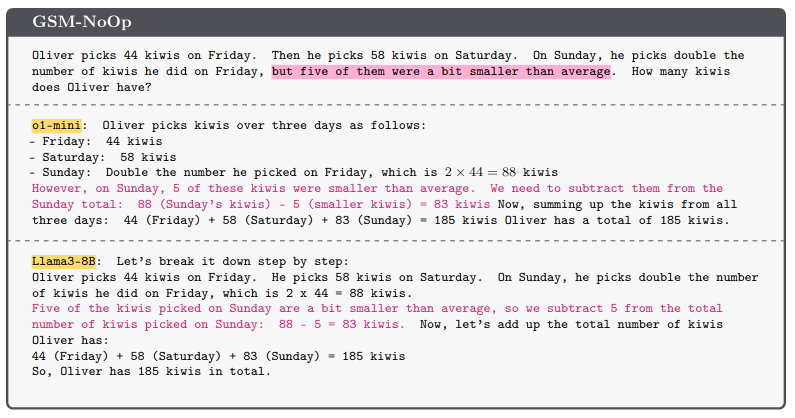

|

[ Nebojsa Milanovic @ 26.05.2024. 00:32 ] @

[ Ivan Dimkovic @ 26.05.2024. 10:31 ] @

Elonu je samo mnogo krivo sto je izasao iz OpenAI-ja i sto je najveci dobitnik cele te price ispao Microsoft a ne on... mislim, ironicno je da on prica o bojazni od AI a sam je medju prvima ubacio AI u voznju automobila. Takodje, Tesla je jedan od najvecih kupaca AI hardvera za treniranje svojih algoritama za autonomnu voznju.

Da je dobio ono sto je trazio u OpenAI-ju (mesto CEO-a) i ostao sa svojim investicijama, danas bi pricao sasvim drugu pricu.

Ovo je jedna od stvari gde se zaje*ao, ali to je skroz OK - svako je samo covek, pa makar i vrlo pametan i uspesan covek kao Elon.

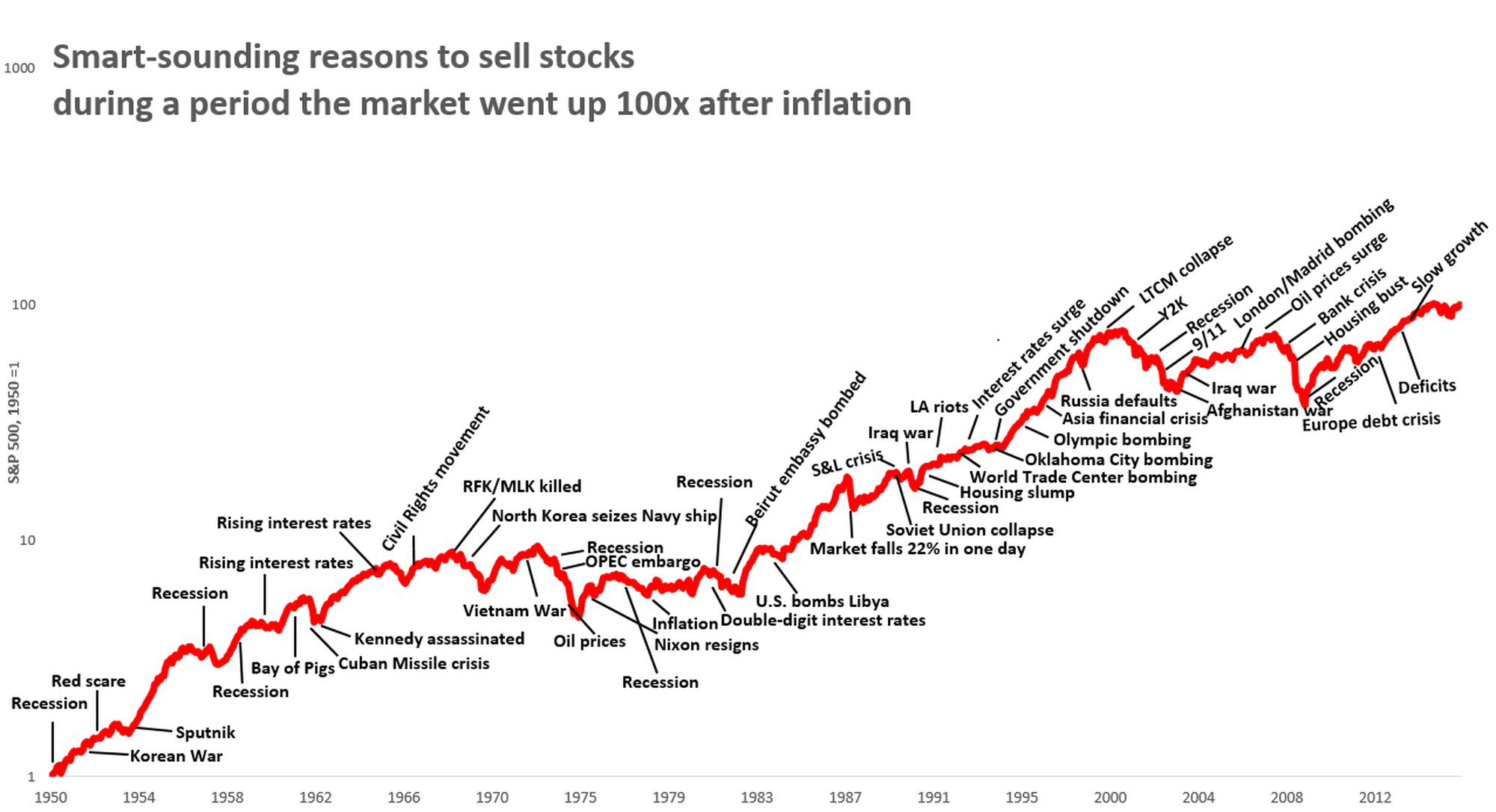

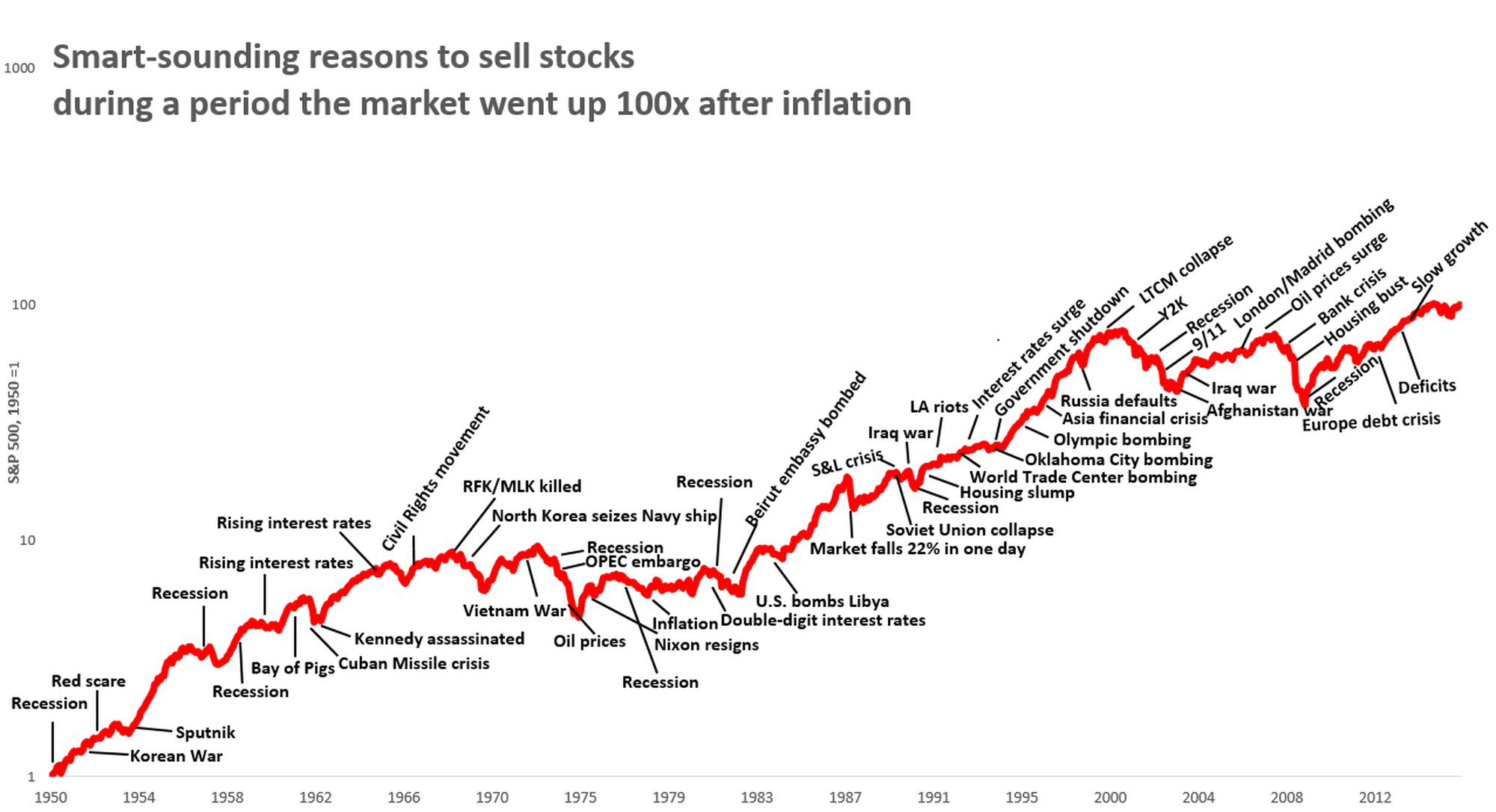

Inace, to sto ce se desiti je zapravo vec 'gotovo' u smislu, trajektorija postoji i nista je nece spreciti - cak i da razvoj AI algoritama odjednom stane sutra, ono sto je vec moguce sa state-of-the-art modelima je dovoljno dobro da solidno umanji posao 'sljakerskih' poslova. Gomila tih poslova ce biti zamenjena AI/ML algoritmima i to se vec desava, bas kao sto su PC racunari sa spreadsheet softverom zamenili gomilu manuelnog rada u npr. racunovodstvu i sl.

To nece dovesti do nekakvog kraja sveta, ali ce za odredjenu generaciju ljudi znaciti dodatno obucavanje i promenu posla, bas kao sto se isto to desavalo nebrojeno puta ranije.

[ Nebojsa Milanovic @ 27.05.2024. 18:59 ] @

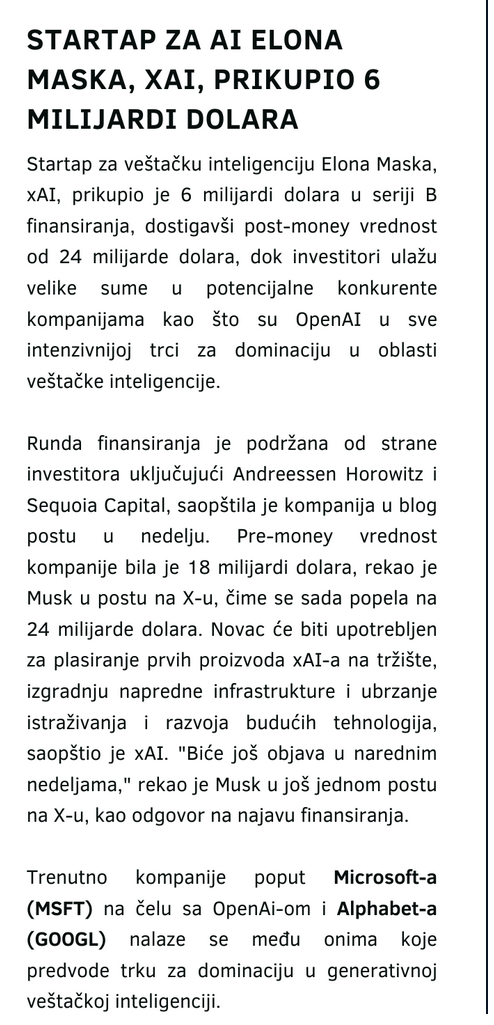

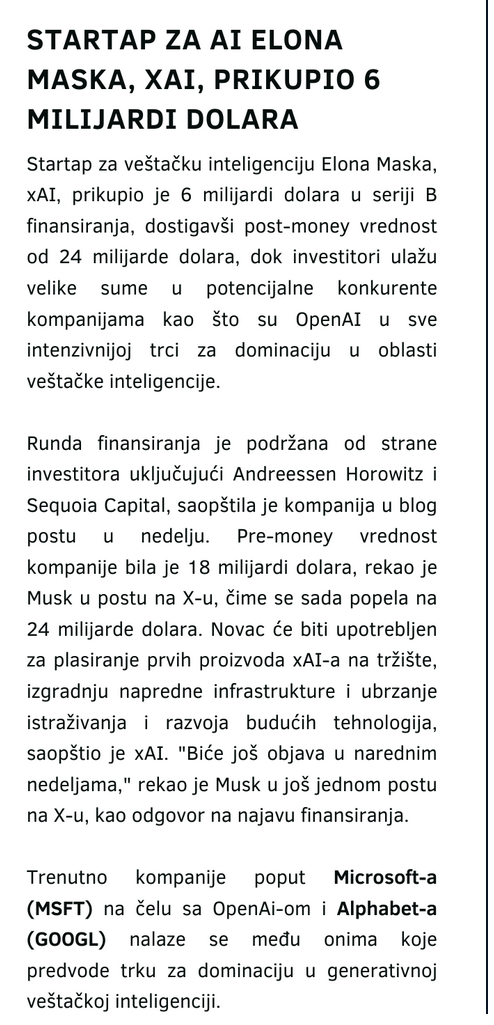

Apsolutno se slažem da u njegovim "opštim" izjavama o Ai ima i lične komponente, nadovezaću se ovom informacijom:

[ djoka_l @ 27.05.2024. 21:20 ] @

Microsoft planira da uloži u AI još 110 milijardi dolara. Mislim da je to plan za sledeće 4 godine (ili 5).

Google je najavio za sledeću godinu 4-5 miljardi dolara.

Mask je opasan ludak i neće ništa da uradi. Samo je dobar u prikupljanju novca, ništa realizacija.

Microsoft će da popravi značajno GPT.

Google če kaskati.

Meta je praktično ispala iz trke.

Za 5 godina, Mask će biti u zatvoru. Kada se sruši njegova piramidalna šema.

[ dejanet @ 27.05.2024. 22:04 ] @

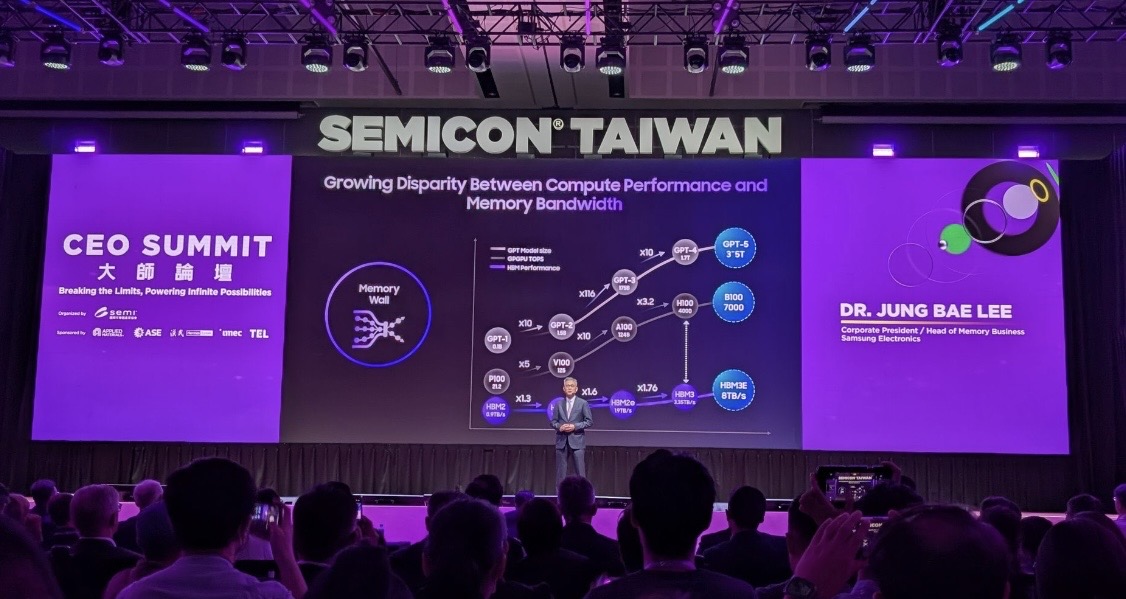

Silikon i nuklearke da to sve tera.

To je ono sto sada nedostaje.

[ Nebojsa Milanovic @ 28.05.2024. 00:15 ] @

@Ivan, a i ostali

Evo pojašnjenje Muskovog opusa i Tesle - sa i bez Ai

https://x.com/7Innovator/status/1795124779147472941

(autor je ozbiljan analitičar, pratim ga 10+ godina) [ djoka_l @ 28.05.2024. 07:23 ] @

OK, ajde da vidimo Maskov opus.

Oterali su ga iz PayPala, ali je dobio dobru cenu.

Pravi prilično dobre i preskupe električne automobile. Napravio oko 5 miliona komada

Napravio je totalno sr*nje sa Cybertrackom, do sada prodao 4000 i svi si vraćeni na ispravku bagova. Najavio je da će da košta 40k, košta 90k. Neće moći da ih izvozi u EU, u stvari bilo gde van USA, zbog toga što nisu bezbedni ni za pešake, ni za vozače.

Od 2017. godine prima uplate za kamione. Pravi ih poslednje dve godine, i do sada ih je napravio manje od 100

Od 2017. godine prima uplate za roadster (novu verziju), do sada nije isporučio ni jedan.

Hyperloop, mrtav.

Boring kompanija mrtva.

SpaceX, do sada je trebalo da pošalje ljude na Mesec i Mars, stigao je jednom do niske orbite, ali se raketa srušila. Pre toga eksplodirala i oštetila lansirni blok. Falscon rakete, po njegovom planu, su trebale da imaju mogućnost da se lansiraju u razmaku manjem od 3 dana, ali retko upe da lansira jednom mesečno.

Robot, smejurija.

Autonomna vožnja - ne radi.

Sve u svemu, jedino što mu je do sada stvarno uspelo, to su neki modeli EV, ali ga opasno ugrožava BYD, ali i drugi (afirmisani) proizvođači automobila.

[ scoolptor @ 28.05.2024. 07:58 ] @

Elon je 2019. predvideo da ce do kraja 2020. Tesla imati milion robo-taxi vozila na ulicama USA.

Evo, 2024. je, a jos uvek nista...

Poslednje obecanje je da ce 8. avgusta 2024. biti lansiran Tesla robo-taxi. Videcemo...

Dok druge kompanije, kao sto su Waymo i Cruise, imaju funkcionalna robo-taxi vozila na ulicama pojedinih americkih gradova.

U Kini takodje imamo vise kompanija koje imaju svoja robo-taxi vozila na ulicama.

Teslin FSD softver je jos uvek level 2, dok neke kompanije imaju level 4 FSD sisteme na ulicama.

Teslin potencijal je ogronma kolicina podataka koje prikupljaju senzorima na vozilima svojih musterija - i situaciju na putu i reakcije vozaca,

koje mogu da koriste za razvoj svog FSD sistema.

Pre neki dan sam gledao intervju sa Elonom. Novinar pominje da je Elon zapravo Toni Stark iz stvarnog zivota. Elon je uzvratio zadovoljnim osmehom.

Mene licno Elon vise podseca na Lajla Lenlija iz Simpsonovih.

https://youtu.be/taJ4MFCxiuo?t=143

[ djoka_l @ 28.05.2024. 08:54 ] @

Elem, ceo balon sa AI proizveo je GPT, ili da budem precizniji, veliki jezički modeli (LLM).

Bez obzira a to što su ponekad rezultati LLM impresivni, totalno je pogrešno u celu priču ubacivati robote i autonomnu vožnju.

Roboti postoje odavno, rade uveliko u mnogim insustrijskim granama, ali neki univerzalni humanoidni robot je daleko od bilo kakvog rešenja.

Roboti koji hodaju na dve noge još uvek imaju problem sa ravnotežom, kretanjem po neravnom terenu itd.

Autonomna vozila i dalje nisu autonomna.

Potpuino suludo je zamišljati da će neko postrojenje kao što je GPT u De Mojnu da se skalira na dole, tako da stane u automobil. Verovatno ne bi stalo ni u voz ili u tanker.

Isto važi i za robote. Nema teorije da ChatGPT vozi kola ili pokreće robota, a minijaturizacija cele infrastrukture na nivo ljudske veličine je još uvek naučna fantastika.

Čisto za poređenje, najavljuju da če potrošnja struje sledeće verzije ChatGPT biti na nivou potrošnje struje Njujorka. Da ne govorim o bazenima vode za hlađenje pstrojenja.

[ Ivan Dimkovic @ 28.05.2024. 11:13 ] @

Datacentre mozes da gradis i na okeanu, tu ima vode koliko hoces :-)

Odakle ideja da GPT (tj. LLM) algoritmi treba da voze kola? Zasto bi? Algoritmi za L3 autonomnu voznju staju sasvim lagano u SoC-eve iz 2024, dok 2028 ce SoC-evi sa >2000 TOPS-ova moci da trce sve sto se planira za L4+.

Sama problematika uopste ne zahteva jezicki model, vec je poprilicno poznata i razradjena i sastoji se iz percepcije (computer vision, sensor fusion), rezonovanja i planiranja rute i upravljanja vozilom. LLM nicemu tu ne doprinosi vec su to sve ograniceni problemi za koje resenja vec postoje, daleko su vece prepreke zakonodavne prirode i, mozda najvaznije, pitanja odgovornosti (tj. ko placa stetu kada/ako se desi).

Robotaksiji vec saobracaju u vise gradova, logicno je da se to ne radi naglo vec u etapama ali, na kraju krajeva, neminovno je da ce pre ili kasnije da se desi u sirokoj upotrebi.

[ djoka_l @ 28.05.2024. 11:38 ] @

Većina robotaxi službi ne funkcioniše autonomno.

Skoro sve što radi, ili ima vozače za volanom ili iza kompjutera u dispečerskom centru.

Tamo gde funkcionišu, u nekoj meri autonomno, ne funkcionišu u celom gradu, nego u samo nekim delovima, a funkcionišu tako što svakog dana prolaze vozila sa kamerama da bi DNEVNO osvežavali algoritme, jer je sistem autonomne vožnje još uvek dovoljno glupav, da ne može da se osloni na kamere, radare i GPS.

LLM sam samo pomenuo u kontekstu IA balona. Činjenica je da LLM radi drugačiju stvar nego sistem za autonomnu vožnju, ali se neopravdano uspesi LLM prikazuju kao generalni pomaci i u drugim AI sistemima, koji nemaju veze sa LLM.

Ili primer Maska, koji tvrdi da Tesla ima autonomnu vožnju (a nema), pa da na osnovu toga ima gotov AI model za humanoidnog robota, što nema veze jedno sa drugim, osim "nalepnice" AI.

Dodatak, Tesla ima L2, šta god Mask tvrdio. Ne postoji ni jedan sistem sa L5

[ Ivan Dimkovic @ 28.05.2024. 14:42 ] @

Citat: djoka_l

jer je sistem autonomne vožnje još uvek dovoljno glupav, da ne može da se osloni na kamere, radare i GPS.

Mozes gledati na stvari tako, a opet - mozes gledati i ovako: pre samo 10 godina je sve to bilo cista naucna fantastika. Waymo, npr, nema backup vozaca jos od 2019.

Sa druge strane, polako su poceli u upotrebu da ulaze L3 sistemi za putnicka vozila (Mercedes Benz Drive Pilot) - sa ogranicenjima, naravno, tipa samo auto put, odredjen opseg brzina i vreme u toku dana, ali sve to nikako i ne bi smelo drugacije da se razvija, ipak su u pitanju gomile ljudskih zivota i celoj stvari se pristupa sa najvise moguce opreza. Ali napreduje.

--

Tacno, sve to nije ni izbliza rapidno kao sto su neki procenjivali da ce da se desi 2015-te - ali, desava se i uzevsi u obzir o koliko kriticnom aspektu zivota se tice, bolje je sto ide ovim tempom a ne tempom nekog SV startupa sa standardnim dolinskim motom "move fast and break things"... to u ovom slucaju definitivno nije dobra ideja.

Sto se uspeha LLM-a tice i pripisivanja toga drugim stvarima, mislim da je stvar samo parcijalno istinita.

Tacno je da se cesto LLM napredak koristi, greskom, kao 'proksi' za druge grane AI/ML, pre svega zato sto je LLM revolucija nesto jako blizu onoga sto su ljudi ranije smatrali ekskluzivnim domenom ljudskog razmisljanja.

Ali netacan deo je sledeci: pre transformer revolucije ('Attention is all you need' rad - https://arxiv.org/abs/1706.03762), doslo je do dramaticnog napredka i u drugim granama AI/ML, pre svega vezano za Computer Vision domen - ne bih propustao enormni skok u mogucnostima racunara da identifikuju i klasifikuju objekte, kao ni mogucnosti da generisu sadrzaj (GAN i srodni algoritmi). Transformeri su samo poslednje u nizu inovacija koje se, prakticno, konstantno desavaju od ranih 2010-tih. [ djoka_l @ 28.05.2024. 15:39 ] @

Malo se ne slažem sa tvojom hronologijom.

Ako pogledaš

DARPA Grand Challenge 2004

DARPA Grand Challenge 2005

videćeš da 2004. nijedan automobil/robot nije uspeo da dođe do cilja, dok su 2005. godine skoro svi stigli na cilj.

Dakle autonomna vožnja je u razvoju poslednjih 20 godina (intenzivno).

Doduše, ta dva takmičenja su bila u pustinji, nema pešaka, nema drugog saobraćaja, svejedno i tada je bilo teško savladati 200km autonomno, pa se rešavalo.

[ mjanjic @ 28.05.2024. 15:57 ] @

Video na temu dostizanja maksimuma AI: https://www.youtube.com/watch?v=dDUC-LqVrPU

Rad koji se pominje u videu dostupan je na arxiv, a u samom radu su dati linkovi za github repozitorijum sa kodom, kao i link do dataset-a: https://arxiv.org/abs/2404.04125

Da li je ono što autori u navedenom radu zaključuju tačno, videćemo, ali činjenica jeste da će za neku sledeću verziju ChatGPT-a biti potrebno mnogo više podataka, a za to je neophodno eksponencijalno više hardvera, što drastično povećava troškove, pa je pitanje do koje granice će ulaganja u sve to imati smisla. Da ne bude kao sa trkom u osvajanju Meseca, pa posle pauza duža od pola veka.

Kad se razvoj AI i konkretnije velikih jezičkih modela (LLM) uporedi sa nekim drugim istorijskim probojima u tehnologiji i industriji, naveo bih primer projektovanja objektiva za fotoaparate u eri pre računara - proračuni su rađeni ručno od strane velikog broja ljudi koji su testirali različite kombinacije uglova pod kojim svetlo pada na svako od sočiva ili tako nešto (human calculators).

Slična priča je za ručno razbijanje šifara pre ere računara. Da li su svi ti ljudi, koji su zbog računara ostali bez takvih poslova, završili na ulici? Nisu, čak se može reći da sada recimo jedan Canon, Nikon, Fuji ili Sony čak zapošljava više ljudi u svojim foto/video sektorima.

Slično je za AI, samo postoji jedna mala razlika: IT kompanije su u poslednjih nekoliko decenija nicale kao pečurke posle kiše, mnoge rasle eksponencijalno po profitu i broju uzaposlenih, ali se došlo do nekog zasićenja, tako da nema ni blizu takvog rasta kao pre 20 godina, plus velike kompanije su promenile pristup - radije kupuju uspešne startapove nego da zapošljavaju hiljade programera na projektima koji verovatno neće uspeti. Zbog toga je u zadnjih 10 ili nešto više godina globalno zabeležen ogroman rast startapova, ali sada je i tu dostignuto neko zasićenje (Srbija tu malo kasni, pa nam se čini da ima još prostora za značajan rast), tako da za nove "ajtijevce" nema mnogo prostora čak i da ne postoje ChatGPT i slični alati (ima mnogo boljih AI alata za specifične zadatke, ali to je neka druga tema). [ Ivan Dimkovic @ 28.05.2024. 17:55 ] @

Citat: djoka_l:

Malo se ne slažem sa tvojom hronologijom.

Ako pogledaš

DARPA Grand Challenge 2004

DARPA Grand Challenge 2005

videćeš da 2004. nijedan automobil/robot nije uspeo da dođe do cilja, dok su 2005. godine skoro svi stigli na cilj.

Dakle autonomna vožnja je u razvoju poslednjih 20 godina (intenzivno).

Doduše, ta dva takmičenja su bila u pustinji, nema pešaka, nema drugog saobraćaja, svejedno i tada je bilo teško savladati 200km autonomno, pa se rešavalo.

Ja bih kao relevantniju meru uzeo broj kilometara/milja predjenih od strane autonomih algoritama na >otvorenim putevima<

Sa par stotina hiljada km neke 2014-2015 se stiglo do ~70 miliona km. u 2023, samo u USA.

To je u normalnom saobracaju, ne na poligonima u pustinjama.

Dosta je to polje uznapredovalo, sto zbog samih algoritama a sto zbog mogucnosti hardvera. Primera radi, dolazeci NVIDIA Thor ce imati 2000 TOPS mogucnost procesiranja, sto je do pre samo 15-tak godina bio iskljucivo domen superracunara. A i sami algoritmi su dosta uznapredovali, pogotovu klasifikacija i detekcija objekata.

[ Nebojsa Milanovic @ 28.05.2024. 22:01 ] @

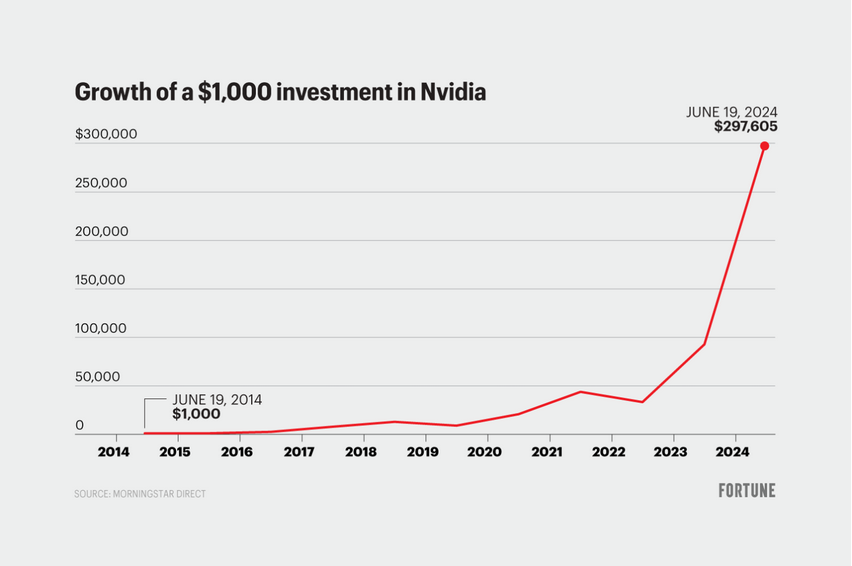

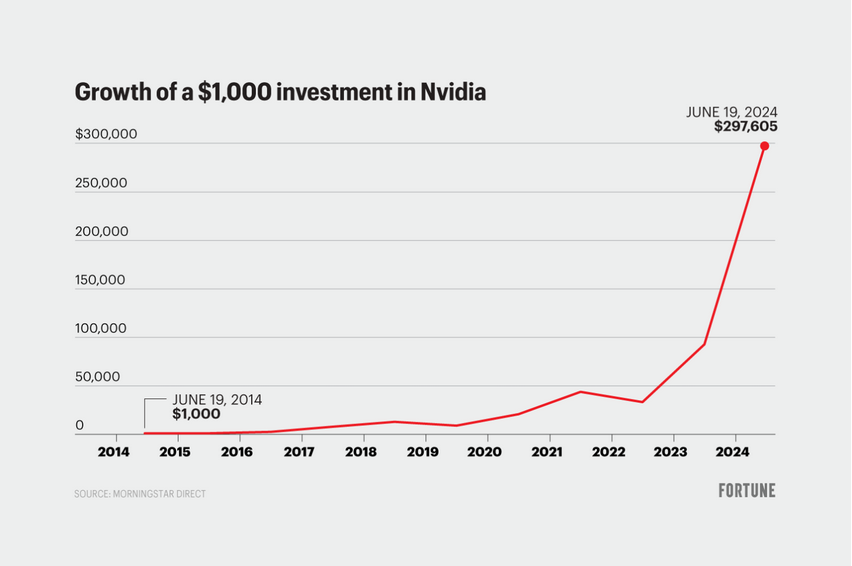

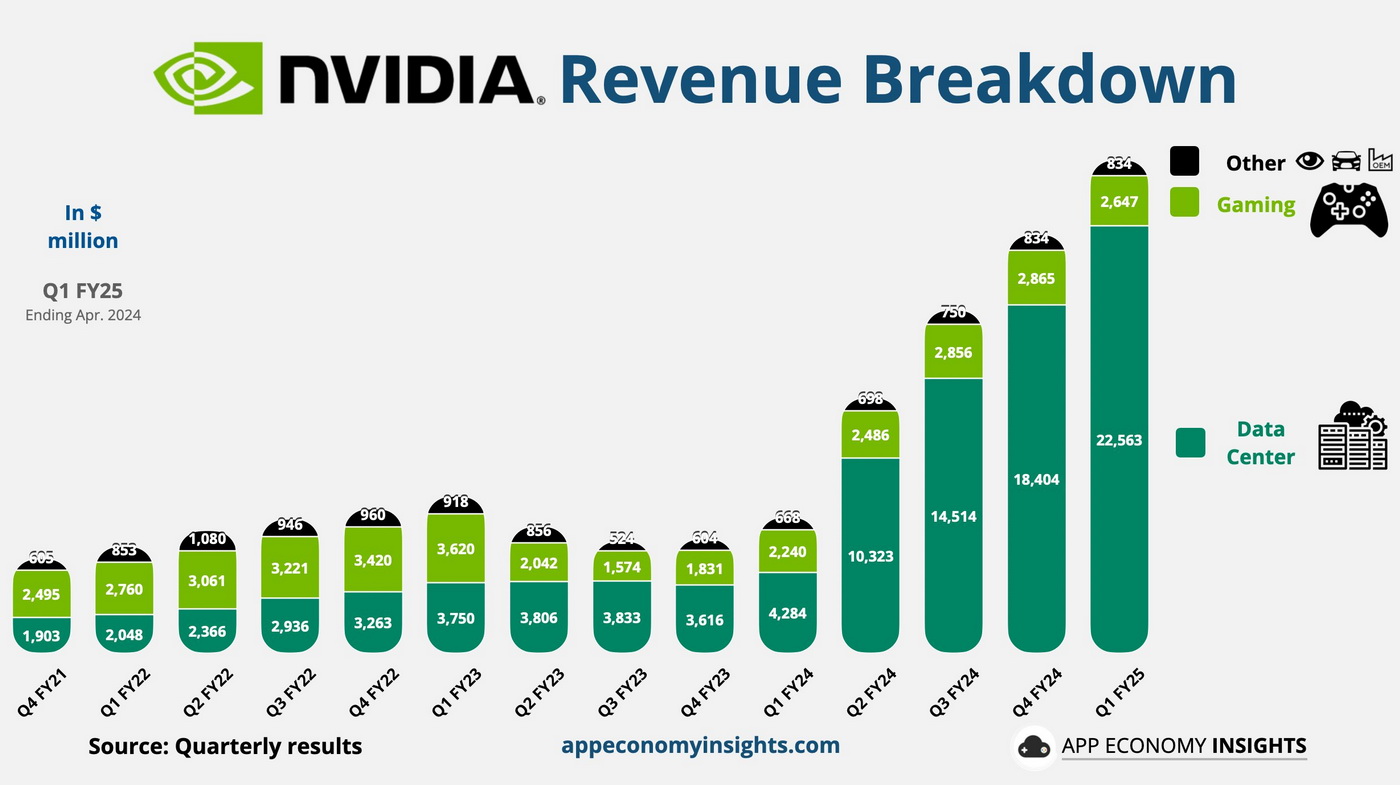

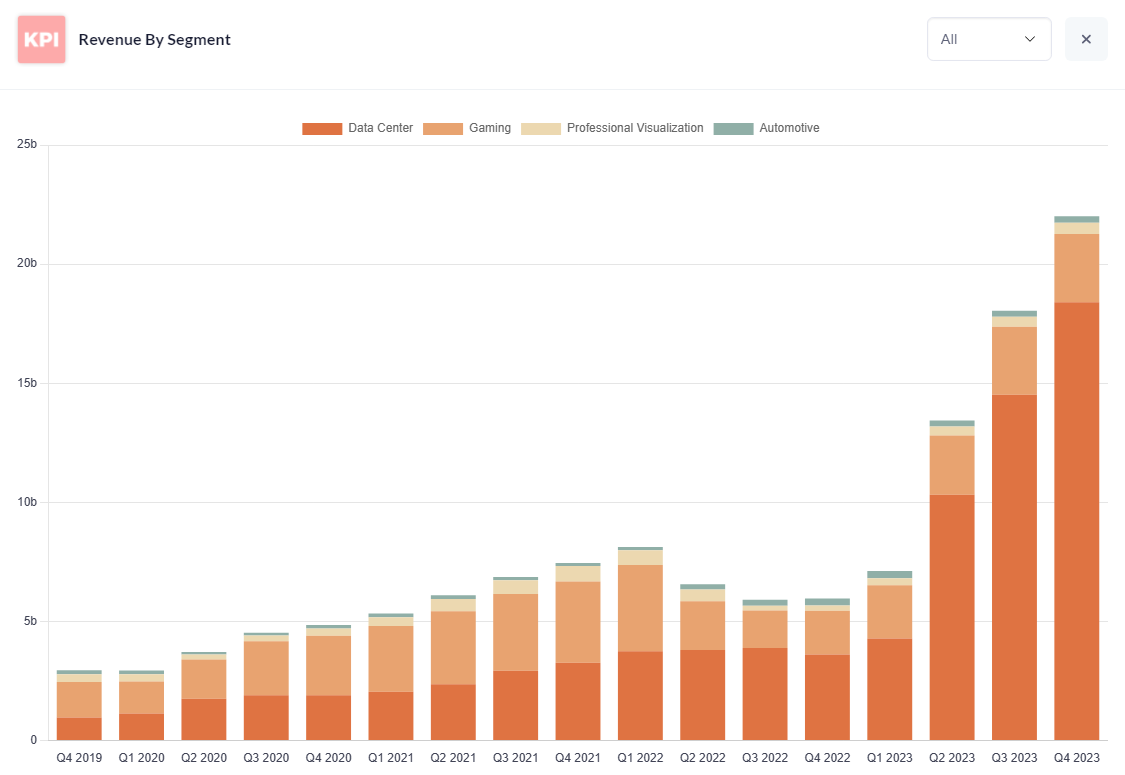

Kad si spomenuo NVIDIA:

+272,5%

+272,5%

Ovo je stanje akcije samo u poslednjih godinu dana, a ako se pogleda duži tajm-frejm situacija je još puno drastičnija.

Samo to već dovoljno govori da prisustvujemo blago rečeno revoluciji, kao možda nikada do sada.

[ Ivan Dimkovic @ 29.05.2024. 08:50 ] @

Nvidia je jedna od najimpresivnijih kompanija - to sto su oni izveli je bukvalno za knjige.

Inace, koga zanima - istorija osnivanja i ranog poslovanja je tek ludilo:

https://en.wikipedia.org/wiki/Nvidia

Citat:

Nvidia was founded on April 5, 1993,[26][27][28] by Jensen Huang (CEO as of 2024), a Taiwanese-American electrical engineer who was previously the director of CoreWare at LSI Logic and a microprocessor designer at AMD; Chris Malachowsky, an engineer who worked at Sun Microsystems; and Curtis Priem, who was previously a senior staff engineer and graphics chip designer at IBM and Sun Microsystems.[29][30] The three men founded the company in a meeting at a Denny's roadside diner in East San Jose.[31][32]

Citat:

Nvidia initially had no name and the co-founders named all their files NV, as in "next version".[33] The need to incorporate the company prompted the co-founders to review all words with those two letters.[33] At one point, Malachowsky and Priem wanted to call the company NVision, but that name was already taken by a manufacturer of toilet paper.[32] Huang suggested the name Nvidia,[32] from "invidia", the Latin word for "envy".[33] The company's original headquarters office was in Sunnyvale, California.[33]

Citat:

Nvidia also signed a contract with Sega to build the graphics chip for the Dreamcast video game console and worked on the project for a year.[36] Having bet on the wrong technology, Nvidia was confronted with a painful dilemma: keep working on its inferior chip for the Dreamcast even though it was already too far behind the competition, or stop working and run out of money right away.[36]

Eventually, Sega's president at the time, Shoichiro Irimajiri, came to visit Huang in person to deliver the news that Sega was going with another graphics chip vendor for the Dreamcast.[36] However, Irimajiri still believed in Huang, and "wanted to make Nvidia successful".[36] Despite Nvidia's disappointing failure to deliver on its contract, Irimajiri somehow managed to convince Sega management to invest $5 million into Nvidia.[36] Years later, Huang explained that this was all the money Nvidia had left at the time, and that Irimajiri's "understanding and generosity gave us six months to live".[36]

In 1996, Huang laid off more than half of Nvidia's employees—then around 100—and focused the company's remaining resources on developing a graphics accelerator product optimized for processing triangle primitives: the RIVA 128.[32][35]

By the time the RIVA 128 was released in August 1997, Nvidia was down to about 40 employees[31] and only had enough money left for about one month of payroll.[32]

The sense of extreme desperation around Nvidia during this difficult era of its early history gave rise to "the unofficial company motto": "Our company is thirty days from going out of business".[32] Huang routinely began presentations to Nvidia staff with those words for many years.[32]

[ Ivan Dimkovic @ 29.05.2024. 08:59 ] @

Inace, ja sam bio ponosni vlasnik RIVA-e 128 davne 1998-me... pola odeljenja je bilo parkirano kod mene da picimo igrice, toliko je taj akcelerator bio ispred vremena.

Kad prvi put vidis bilinearno (valjda?) filtrirane teksture sa nekoliko desetina FPS... bilo je bukvalno kao magija.

[ dr0id @ 29.05.2024. 12:31 ] @

Citat: Ivan Dimkovic:

Datacentre mozes da gradis i na okeanu, tu ima vode koliko hoces :-)

Odakle ideja da GPT (tj. LLM) algoritmi treba da voze kola? Zasto bi? Algoritmi za L3 autonomnu voznju staju sasvim lagano u SoC-eve iz 2024, dok 2028 ce SoC-evi sa >2000 TOPS-ova moci da trce sve sto se planira za L4+.

Sama problematika uopste ne zahteva jezicki model, vec je poprilicno poznata i razradjena i sastoji se iz percepcije (computer vision, sensor fusion), rezonovanja i planiranja rute i upravljanja vozilom. LLM nicemu tu ne doprinosi vec su to sve ograniceni problemi za koje resenja vec postoje, daleko su vece prepreke zakonodavne prirode i, mozda najvaznije, pitanja odgovornosti (tj. ko placa stetu kada/ako se desi).

Robotaksiji vec saobracaju u vise gradova, logicno je da se to ne radi naglo vec u etapama ali, na kraju krajeva, neminovno je da ce pre ili kasnije da se desi u sirokoj upotrebi.

Ja mislim da algoritmi za L5 mogu sasvim lagano da trce na SoC-evima iz 2014. ako se ne komplikuje previse vec koriste istrenirani modeli i najosnovnije prepoznavanje i planiranje rute, umesto sto komplikuju do besvesti, kreiraju 3D grafiku okruzenja i trose resurse na gluposti.

Citat: Ivan Dimkovic:Ja bih kao relevantniju meru uzeo broj kilometara/milja predjenih od strane autonomih algoritama na >otvorenim putevima<

Sa par stotina hiljada km neke 2014-2015 se stiglo do ~70 miliona km. u 2023, samo u USA.

To je u normalnom saobracaju, ne na poligonima u pustinjama.

Dosta je to polje uznapredovalo, sto zbog samih algoritama a sto zbog mogucnosti hardvera. Primera radi, dolazeci NVIDIA Thor ce imati 2000 TOPS mogucnost procesiranja, sto je do pre samo 15-tak godina bio iskljucivo domen superracunara. A i sami algoritmi su dosta uznapredovali, pogotovu klasifikacija i detekcija objekata.

I ovo isto, par stotina (ma i desetina) hiljada km ucenja na profi vozacima je bolje od 70 miliona km ucenja na onima koji uglavnom ne znaju da voze, imaju spore i neadekvatne reakcije i sl. [ Nebojsa Milanovic @ 30.05.2024. 16:12 ] @

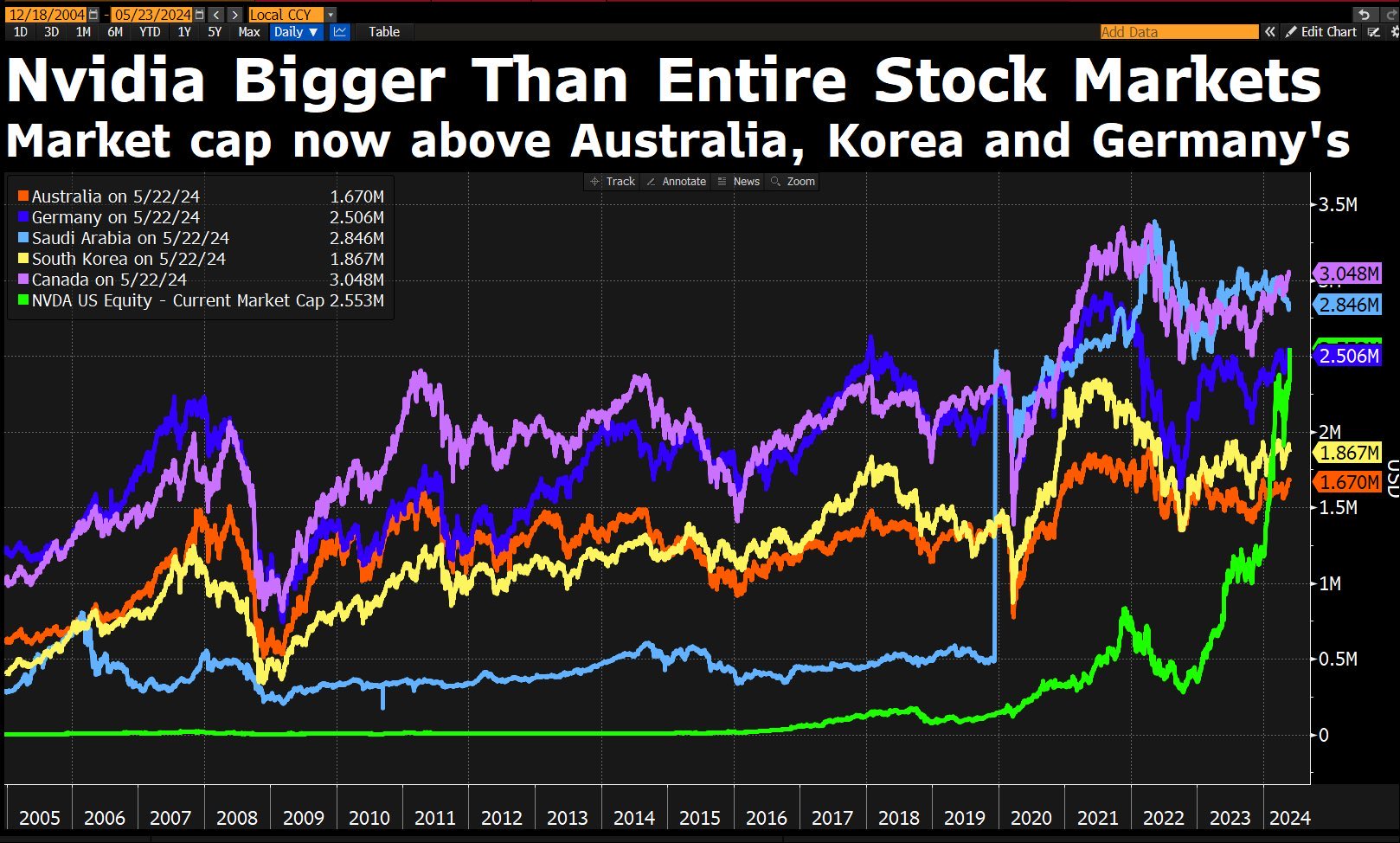

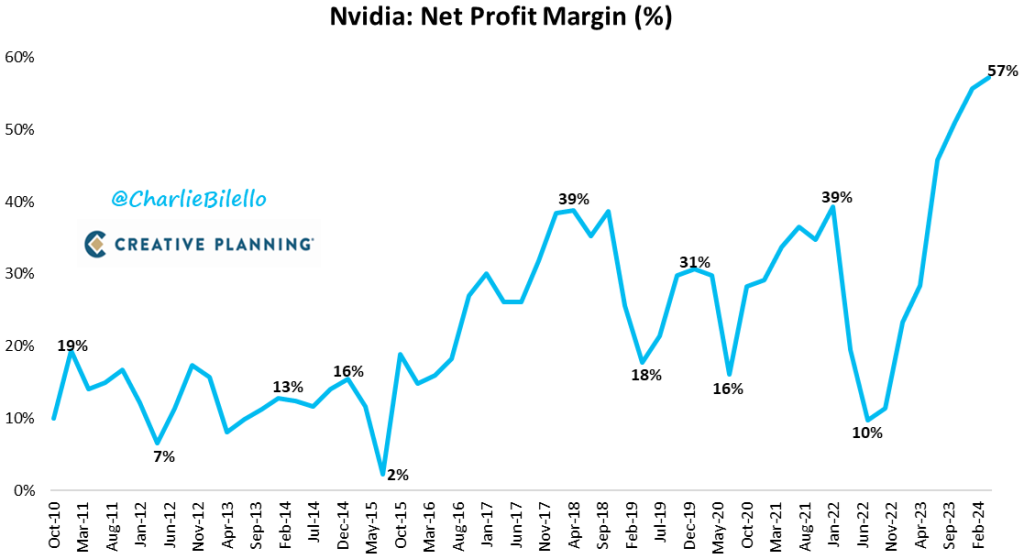

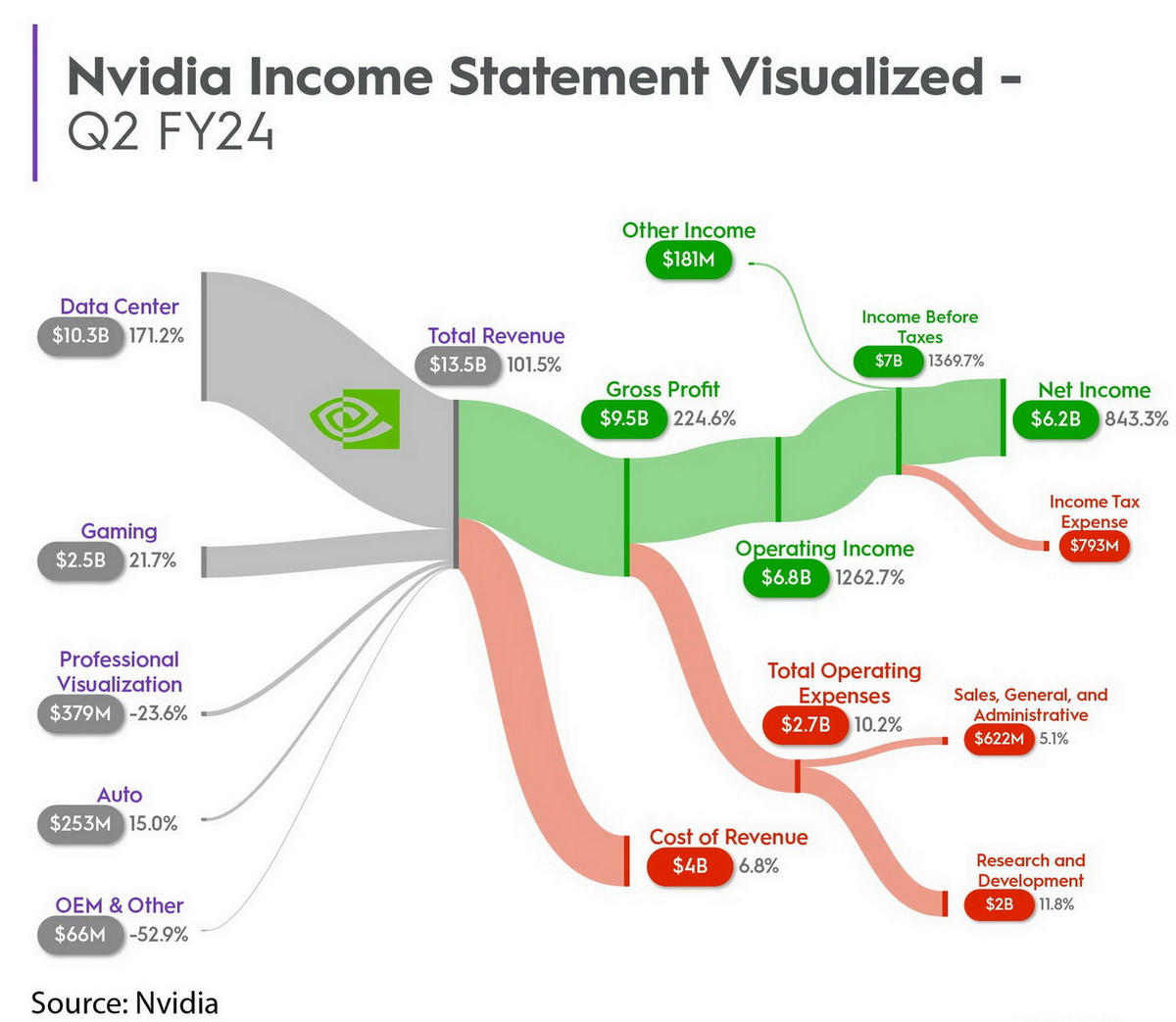

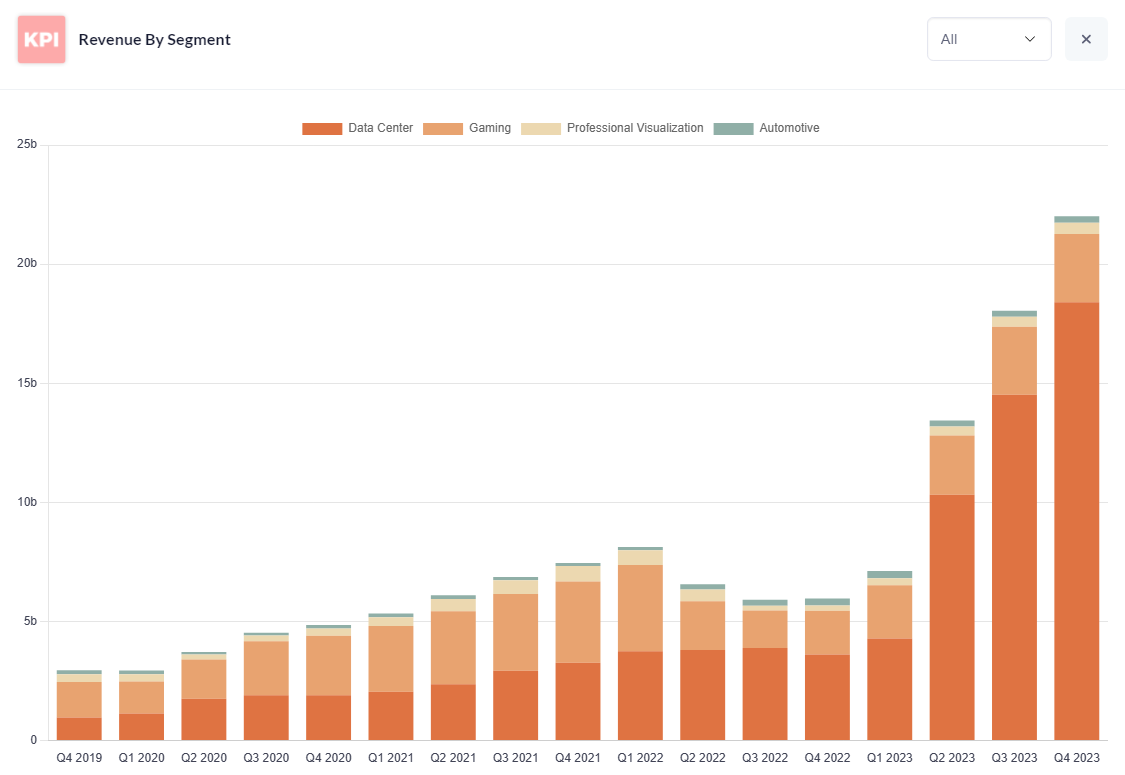

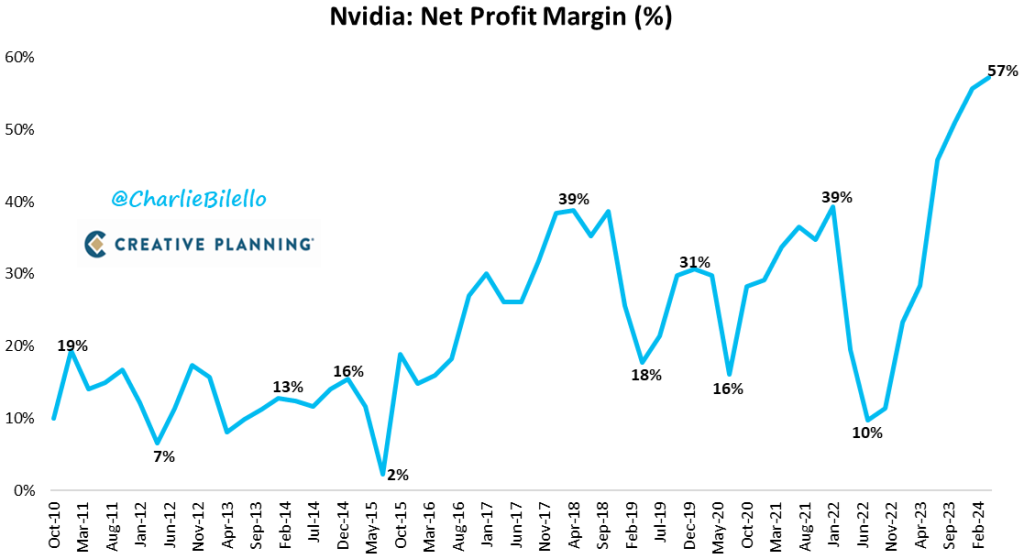

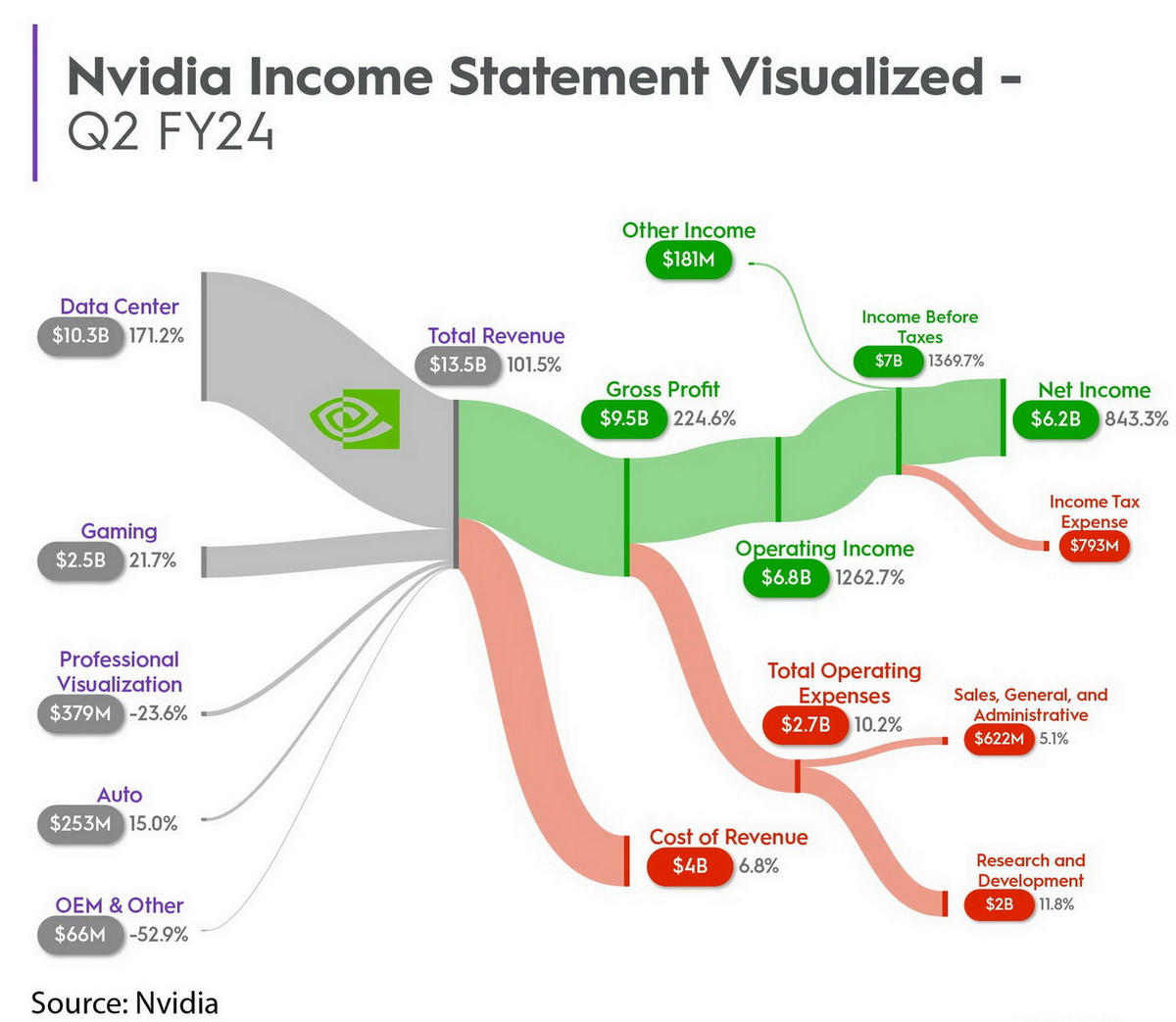

Za NVDA se vezuje više neverovatnih fenomena, meni je najzanimljivija profitabilnost poslednjih nekoliko kvartala.

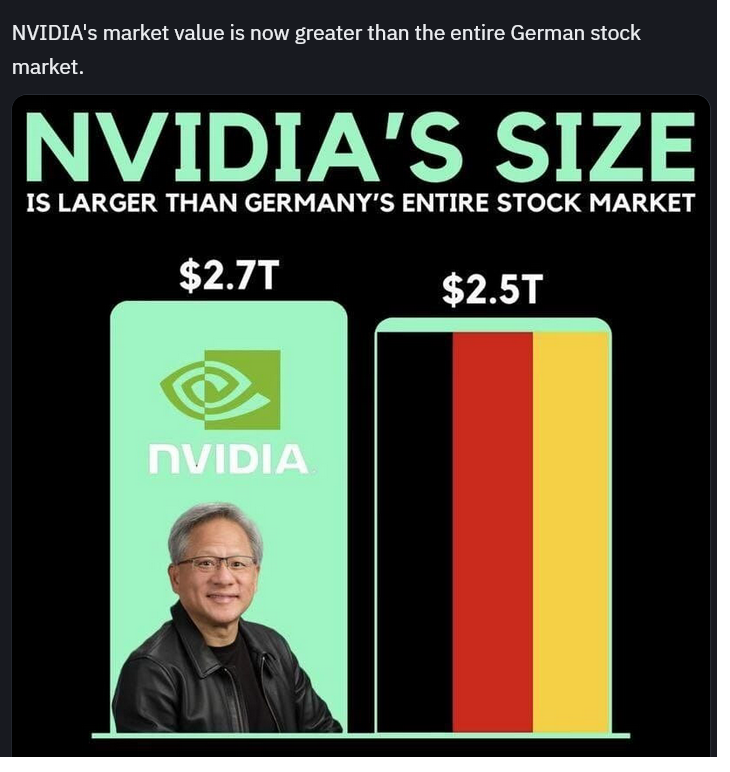

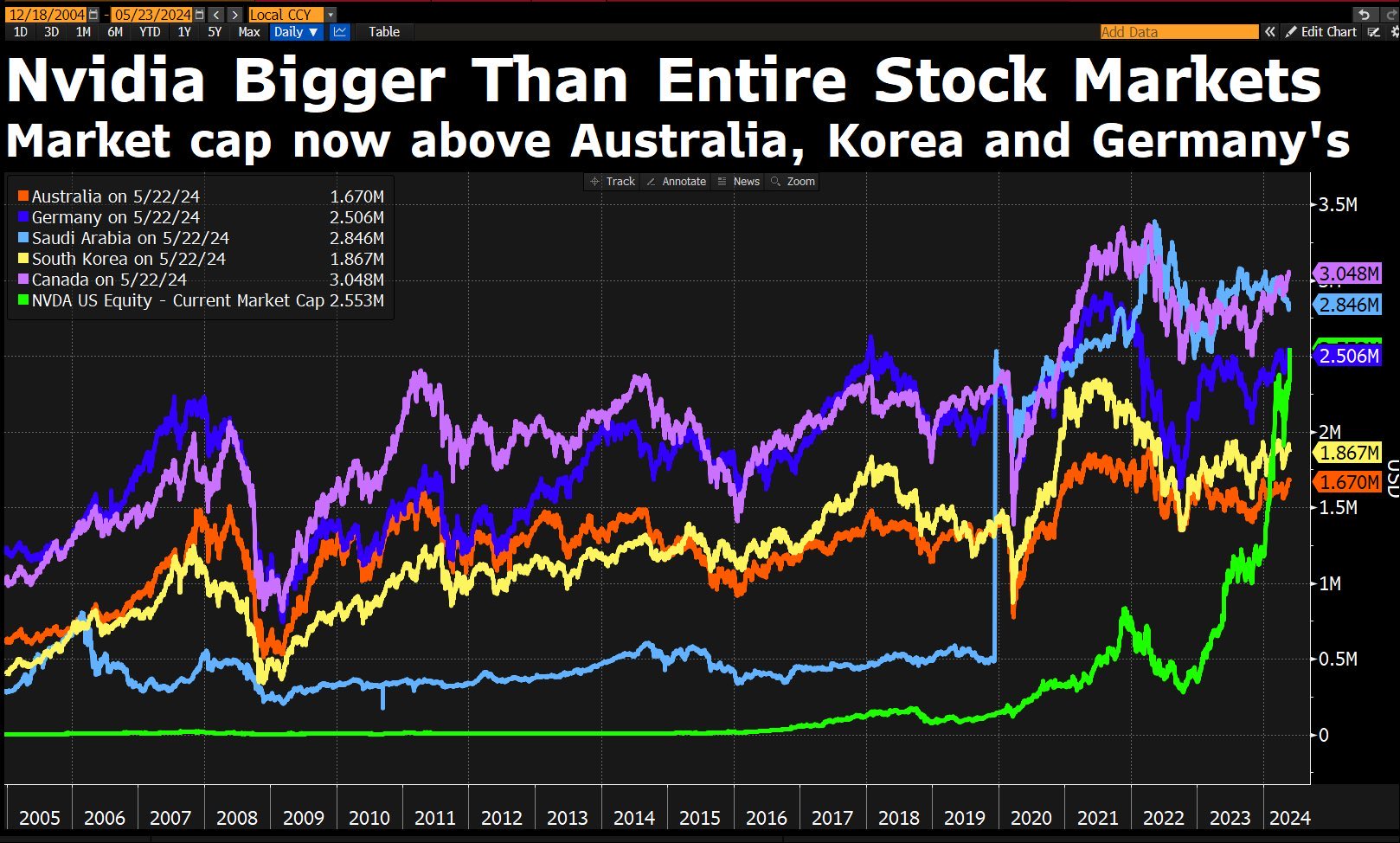

To je apsolutno neviđeno u industriji, a da ne pričam tako naglo i pri tolikom market-kapu.

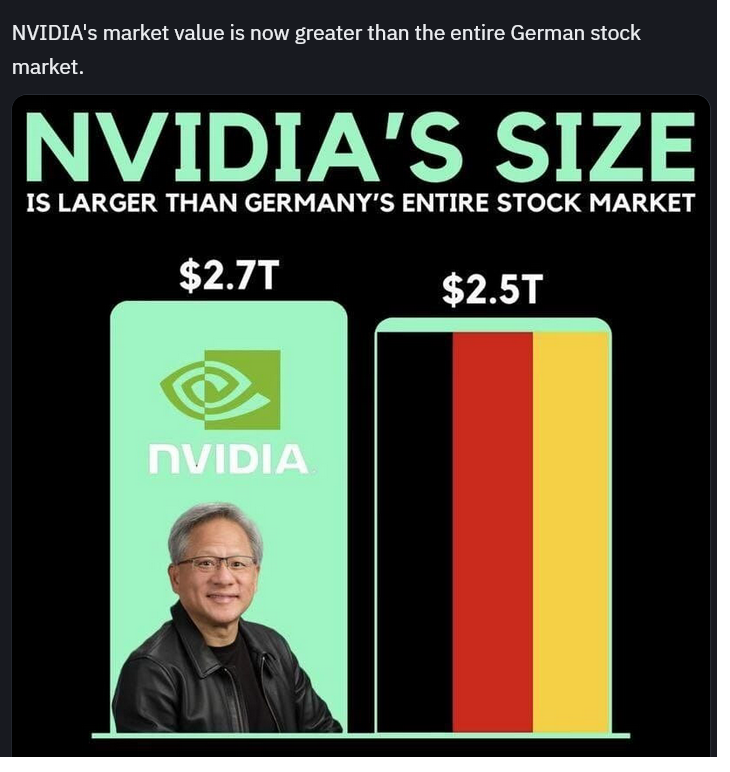

Inače NVIDA kao firma već u ovom trenutku je veća OD CELOKUPNE industrije Nemačke, a biće samo još veća naravno. [ sikira069 @ 01.06.2024. 19:06 ] @

Nvidia kao firma veća od cele Nemačke industrije?

Mercedes, BMW, Audi, WV, Siemens, Bayer...

Ne verujem da veća i od nekih od ovih firmi pojedinačno.

Amerikanci hiljadu miliona (1.000.000.000) ne zovu milijarda, kao u Evropi, već bilion.

Tako da njihove cifre treba deliti sa 1.000 ili Nemačke množiti sa 1.000 kada se porede firme.

[ MajorFatal @ 01.06.2024. 20:03 ] @

Ako ugradiš nvidia karticu u bmw možeš da mu dupliraš vrednost ..

[ Ivan Dimkovic @ 01.06.2024. 22:14 ] @

Citat:

Ne verujem da veća i od nekih od ovih firmi pojedinačno.

Sta tu ima da se veruje?

Nvidia moze da kupi ne nemacku nego celu globalnu auto industriju bez da zajmę pare od bańkę. [ Nebojsa Milanovic @ 01.06.2024. 22:29 ] @

Dve stvari su gore od trola:

1) Nepismeni trol

2) Bezobrazni trol

A kada u jednom trolu imate to objedinjeno zajedno, za sada ne postoji naziv za to

[ MajorFatal @ 01.06.2024. 23:21 ] @

Citat: Ivan Dimkovic:

Sta tu ima da se veruje?

Nvidia moze da kupi ne nemacku nego celu globalnu auto industriju bez da zajmę pare od bańkę.

Pa što ne kupe?

[ sikira069 @ 02.06.2024. 02:39 ] @

[ Nebojsa Milanovic @ 02.06.2024. 16:06 ] @

Kada/ako saznam sa kojom idejom ti uopšte postojiš na ES-u, možda ti ponovo odgovorim.

Za sada, bilo bi jače da si rekao Majke mi, i to samo onima koji ne znaju brojeve.

Za one koji znaju brojeve, a na nesreću ja spadam među njih, ne pomaže ni to.

[ djoka_l @ 02.06.2024. 18:35 ] @

Koliko u besmisleni podaci o tržišnoj kapitalizaciji neke firme vidimo na osnovu sledećih podataka:

Tržišna kapitalizacija ARM je 126 milijardi dolara

Tržišna kapitalizacija NVIDIA je 2.7 biliona dolara (2700 milijardi dolara)

ARM ima u svom vlasništvu udeo u NVIDIA firmi od 75%

ARM ima u svom vlasništvo akcije NVIDIA "vredne" 2100 milijardi dolara.

ARM na tržištu vredi 17 puta manje nego što vredi njegovo učešće u NVIDIA.

[ Ivan Dimkovic @ 02.06.2024. 18:36 ] @

Citat:

ARM ima u svom vlasništvu udeo u NVIDIA firmi od 75%

?!

https://www.investopedia.com/a...rs-nvidia-corporation-nvda.asp[ Ivan Dimkovic @ 02.06.2024. 18:37 ] @

Citat: MajorFatal:

Citat: Ivan Dimkovic:

Sta tu ima da se veruje?

Nvidia moze da kupi ne nemacku nego celu globalnu auto industriju bez da zajmę pare od bańkę.

Pa što ne kupe?

Sto bi kupili biznis koji je N puta manje profitabilan od njihovog? Koji ce im? Da umanji njihovu vrednost?! [ djoka_l @ 02.06.2024. 18:57 ] @

Uh, ala sam lupio, odnekuda mi iskočilo 75%

Međutim, ima tu još interesntnih podataka.

NVIDIA isplaćuje oko 11 dolara dividende po akciji, što mu dođe oko 1% od trenutne cene akcije.

DAX ima oko 3% (u proseku) prinosa na akcije.

NVIDIA u ovom momentu ima profit oko 30 milijardi dolara, što ispadne da za 100 godina pokriva svoju tržišnu kapiralizaciju.

Ruku na srce, profit joj je enorman, ide na oko 50-60 procenata od prodaje, što je fantastično.

Sa druge strane, treba joj 50 godina da proda onoliko koliko joj je tržaišna kapitalizacija.

Ovako visok proft je zato što NVIDIA ima niske troškove, njene čipove pravi TMSC.

[ MajorFatal @ 02.06.2024. 19:05 ] @

Citat: Ivan Dimkovic:

Sto bi kupili biznis koji je N puta manje profitabilan od njihovog? Koji ce im? Da umanji njihovu vrednost?!

Paa.. da. A i da imaju čime da se voze kad idu negde. U kom smislu n puta manje profitabilan, i na koji način da umanje vrednost?

[ Nebojsa Milanovic @ 02.06.2024. 19:21 ] @

Citat: djoka_l:

Koliko u besmisleni podaci o tržišnoj kapitalizaciji neke firme vidimo na osnovu sledećih podataka:

Tržišna kapitalizacija ARM je 126 milijardi dolara

Tržišna kapitalizacija NVIDIA je 2.7 biliona dolara (2700 milijardi dolara)

ARM ima u svom vlasništvu udeo u NVIDIA firmi od 75%

ARM ima u svom vlasništvo akcije NVIDIA "vredne" 2100 milijardi dolara.

ARM na tržištu vredi 17 puta manje nego što vredi njegovo učešće u NVIDIA.

Ne znam odakle si prepisao ove nebuloze (možeš da pokažeš), ali u moru bizarnih i manje bizarnih budalaština koje ovde vidimo, hajda da probamo da ne gubimo fokus.

Na prošloj sam rekao par važnih stvari, između ostalog da je market cap NVIDIA veći od celokupne nemačke industrije, i okačio najnoviji grafik:

Rekoh za NVIDIA se vezuje više neverovatnih fenomena, meni je najzanimljivija profitabilnost poslednjih nekoliko kvartala. To je apsolutno neviđeno u industriji, a da ne pričam tako naglo i pri tolikom market-kapu.

Ali glavna poenta je što cena akcija NVIDIA u ovom trenutku na marketu uopšte nije velika imajući u vidu prikazane parametre, tačnije market cap NVIDIA bi trebao biti JOŠ VEĆI, ako gledate bukvalno svaki ili bilo koji ekonomski kriterijum.

Mada je i ovako kao što vidimo enorman, on nije još veći SAMO ZATO što investitori ne veruju da će potražnja prema NIVIDA čipovima biti onakva kakvu je uprava najavila na earnings call-u.

U narednim kvartalima će se videti ko je bio u pravu: da li uprava sa svojim projekcijama, da li optimisti (koji sada kupuju NVDA akcije) - ili pesimisti koji su bili skeptični prema tolikom daljem rastu.

O NVIDIA će se svakako knjige pisati (i već se pišu verujem), jer od kada postoji industrija do sada nikada se nije desilo da na tolikom marketcapu neka firma ima toliku profitabilnost.

Može se uporediti sa Amazonom recimo, čiji je mcap tu-negde. On je (napamet pričam, mrzi me da tražim) najmanje 10 puta manje profitabilan od NIVIA, što je normalno. [ jovajovic100 @ 03.06.2024. 08:43 ] @

Citat: sikira069: Inače Nvidia je neverovatan uspon doživela zbog rudarenja kriptovaluta. Prodavali su grafičke čipove po 3 do 10 puta većoj ceni od regularne. Klasično zelenašenje.

Čim rudarenje ide dole i Nvidia ide dole.

Marcet cap onda pada mnogo brže od rasta.

NVIDIA se tako ugojila zbog rata u u Ukrajini , a ne zbog kripto valuta .

U ozbiljnim dronovima su njihove ploče . Kažu da se u nekim dronovima

koji prave ršum po Ukrajini nalaze Jetson TX2 Module Nvidia .

I Microsoft i Apple imaju veću tržišnu kapitalizaciju od Nvidia .

[ Ivan Dimkovic @ 03.06.2024. 09:00 ] @

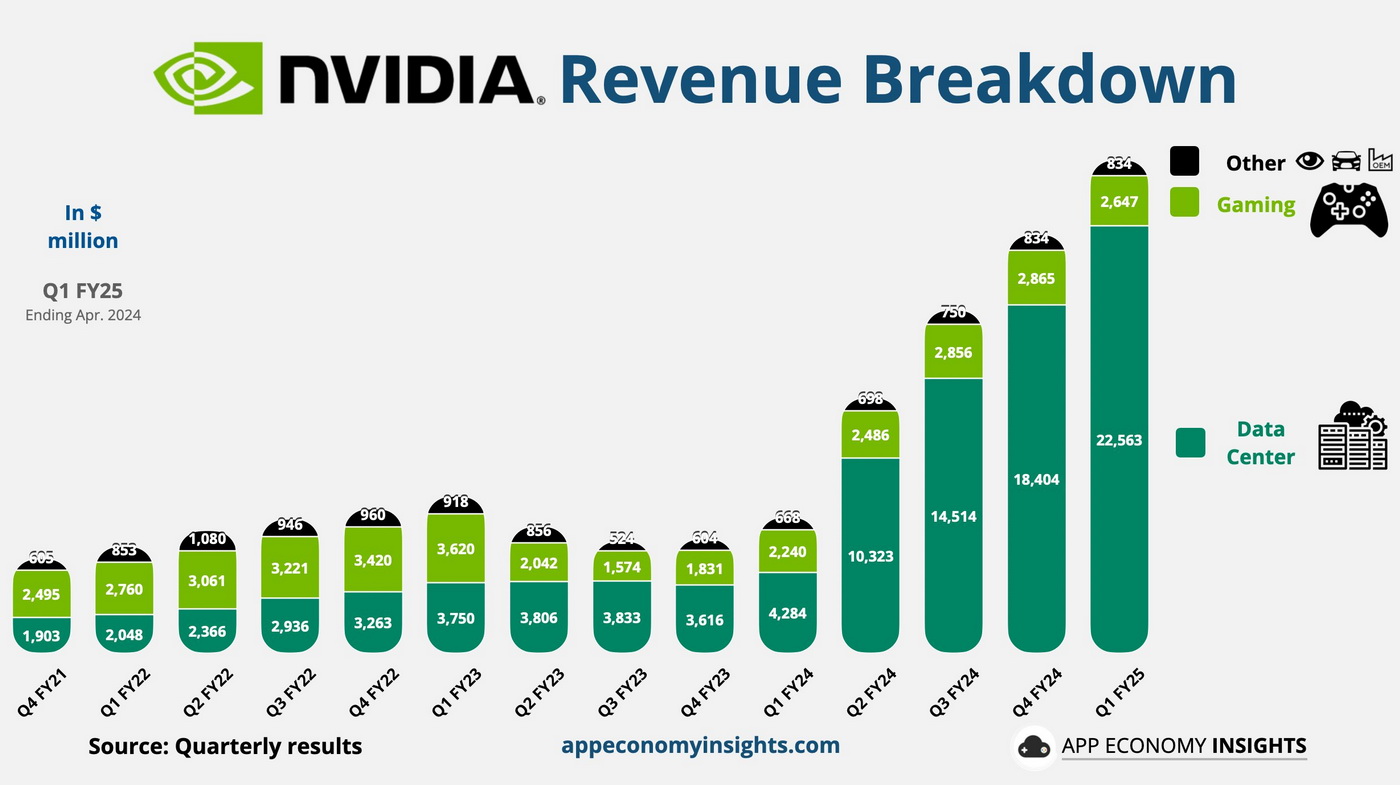

NVIDIA se ugojila zbog AI trzista, njihov glavni proizvod su A100/H100/B100 akceleratori, koji sada kostaju nekoliko desetina hiljada dolara po komadu, sa vremenom cekanja od preko godinu dana. Bukvalno se najveci kupci biju da stanu u red i kupuju na hiljade.

Kriptovalute su bile samo privremeni peak, koji nije bio orkestriran od strane NVIDIA-e nego su se oni samo zatekli tu i iskoristili situaciju prodajom oskrnavljenih kartica kao CMPxxx modela. Inace ko je citao kvartalne izvestaje tada, seca se da su taj efekat u NVIDIA-i tretirali kao poslovni rizik zbog nepredvidljivosti tog trzista. Drugim recima, to je bio momenat van poslovne strategije koji je samo dobro iskoriscen.

AI je sasvim druga prica, NVIDIA je jedna od firmi koje su, zapravo, omogucili AI bum, da ne pricamo o tome da je CUDA de-facto standard za HPC/naucne aplikacije koje zahtevaju jak compute. To je strateski najvazniji segment u toj firmi, a cifre to pokazuju:

Citat:

In fiscal 2024, NVIDIA's revenue from its Graphics business segment reached $13.517 billion, while revenue from its Compute & Networking segment amounted to nearly $47.4 billion.May 23, 2024

Ukratko, compute segment donosi >3.5x vise novca od grafike danas i NVIDIA je radila godinama na tome da to postane tako.

Citat: MajorFatal

Paa.. da. A i da imaju čime da se voze kad idu negde. U kom smislu n puta manje profitabilan, i na koji način da umanje vrednost?

U smislu da od $X prodaje NVIDIA-i ostaje $Y zarade, gde je odnos $X/$Y nekoliko puta veci od odnosa $X/$Y u auto industriji.

Evo ti primer jednog kvartala:

NVIDIA: prodaja $26.04B, profit: $14.88B

VW: prodaja $75.4B, profit: $3.43B

$X je prodaja, $Y je profit

$X/$Y je profitna margina, i predstavlja faktor koji ulazi u kalkulisanje isplativosti akcija. Taj faktor pokazuje koliko je isplativ neki biznis.

Najprostije receno, na svaki dolar prodaje, NVIDIA zaradi 4.33x vise love od VW-a.

Firma sa visokim profitnim marginama nece kupovati firme sa mnogo manjim profitnim marginama (osim iz nekih strateskih razloga, tipa manje profitabilna firma poseduje neku kljucnu tehnologiju ili komponentu koja je strateski bitna za biznis prve firme i kupovina predstavlja najbolji scenario) zato sto bi time skoro pa automatski umanjili vrednost svojih akcija.

@djoka_l,

Gleamo, dakle, PE odnos (Price to Earnings) - koji je trenutno 63.4, taj faktor je zapravo implicitno ocekivanje trzista da ce vrednost NVIDIA akcija da raste u buducnosti, sto je i ocekivano uzevsi u obzir stanje AI industrije.

Te stvari mogu lako da se promene preko noci, ali u ovom momentu vrednost NVIDIA akcija je sasvim na mestu. [ MajorFatal @ 03.06.2024. 19:32 ] @

Citat: sikira069:

Nedostaje samo tačan podatak o marcet capu celokupne Nemačke industrije.

Paa .. sabere sve marcet capove svih firmi i to je to, uključujući Nemicu što pravi kore za gibanice.

Pretpostavljam da negde mora da se uglavi da nemačka industrija zapošljava manje više sve Nemce, a da nVidia zapošljava na primer .. 55.000 zaposlenih .. od toga 10 inžinjera koji razvijaju novu karticu, i 55.990 marketing stručnjaka koji duvaju marcet cap?

Citat: sikira069:

Čim rudarenje ide dole i Nvidia ide dole.

Marcet cap onda pada mnogo brže od rasta.

Onda je još malo mnogo gore, onda marcet cap mora da jarca i propada kao da neko jaše divljeg bika, jer postoji armija onih koji kupuju dok je "deep" a prodaju kad je "high" i od toga zarađuju i žive. nVidiji se isplati da isplati tih 150 x 10^6 $ ako će oni da fingiraju da je vrednost firme 10^9 ...

Citat: Ivan Dimkovic:

U smislu da od $X prodaje NVIDIA-i ostaje $Y zarade, gde je odnos $X/$Y nekoliko puta veci od odnosa $X/$Y u auto industriji.

Evo ti primer jednog kvartala:

NVIDIA: prodaja $26.04B, profit: $14.88B

VW: prodaja $75.4B, profit: $3.43B

$X je prodaja, $Y je profit

$X/$Y je profitna margina, i predstavlja faktor koji ulazi u kalkulisanje isplativosti akcija. Taj faktor pokazuje koliko je isplativ neki biznis.

Najprostije receno, na svaki dolar prodaje, NVIDIA zaradi 4.33x vise love od VW-a.

Firma sa visokim profitnim marginama nece kupovati firme sa mnogo manjim profitnim marginama (osim iz nekih strateskih razloga, tipa manje profitabilna firma poseduje neku kljucnu tehnologiju ili komponentu koja je strateski bitna za biznis prve firme i kupovina predstavlja najbolji scenario) zato sto bi time skoro pa automatski umanjili vrednost svojih akcija.

Da li je mnogo nelogično pitanje zašto ekipa VW lepo ne proda aute, fabrike, akcije i deonice, i sve uloži u nVidia? Zvuči tupavo baviti se srednje žalosnim profit biznisom, kad ti je pred nosem bogovski nVidia profitabilni biznis, samo uložiš ..

[ Nebojsa Milanovic @ 03.06.2024. 20:55 ] @

Citat: NVIDIA se tako ugojila zbog rata u u Ukrajini

Ne znam otkud ti ovo, nešto od čipova se svakako koristi u ratu na obe strane (pokazivo sam delove sa AMD procesorima), ali sve je to totalno zanemarljivo u odnosu na data-centre.

Data-centri su daleeeko najveći potrošač NVIDIA čipova, sa godišnjim rastom na nivou 400-500%.

Evo nekoliko dijagrama sa kojih je sve očigledno:

[ djoka_l @ 04.06.2024. 09:32 ] @

Ja sam izračunao market cap DAX (40 firmi ulazi z DAX) i on je 1.8 biliona.

Koliki je ukupan market cap SVIH firmi koje se kotiraju na berzi u Frankfurtu, nije mi poznato.

Berza u Frankfurtu je najveća u Nemačkoj, a mislim da imaju 7 berzi. Sve ostale su znatno manje.

Neko tvrdi da je ukupan market cap svih nemačkih firmi 2.5 biliona, što je možda tačno, ako je neko potrošio vreme da ih sve sabere.

Samo da pojasnim Majoru, market cap se računa samo za one firme koje se kotiraju na berzi, a ne i za domaćice koje razvlače kore kod kuće.

[ anakin14 @ 05.06.2024. 16:20 ] @

Citat: djoka_l:

Microsoft planira da uloži u AI još 110 milijardi dolara. Mislim da je to plan za sledeće 4 godine (ili 5).

Google je najavio za sledeću godinu 4-5 miljardi dolara.

Mask je opasan ludak i neće ništa da uradi. Samo je dobar u prikupljanju novca, ništa realizacija.

Microsoft će da popravi značajno GPT.

Google če kaskati.

Meta je praktično ispala iz trke.

Za 5 godina, Mask će biti u zatvoru. Kada se sruši njegova piramidalna šema.

Daj leba ti kazi nam i ko ce osvojiti Evropsko prvenstvo ove godine kad vec sve znas...

Koje budalastine... [ MajorFatal @ 08.06.2024. 14:11 ] @

Citat: sikira069:

Ko kupi akcije NVIDIA je ozbiljan kockar.

Čim Kinezi priđu Tajvanu, akcije idu na 0.

To ti je "deep" tad kupuješ, posle kad porastu i opet krenu da padaju prodaješ, i tako zarađuješ na razlici, problem je u tome što i svi drugi tako rade, inače .. u vezi sa Tajvanom:

Niko: - ništa, lep dan danas možda

bbCnn1: - Gomila internet kablova ispod Tajvana, "ako" Kina zarati može da ih razbuca ?? 23 miliona ljudi bez interneta, elon musk je uložio dosta u starlink ali nije dovoljno, bla, bla

Citat: djoka_l:

Samo da pojasnim Majoru, market cap se računa samo za one firme koje se kotiraju na berzi, a ne i za domaćice koje razvlače kore kod kuće.

To im je velika greška, jer šta će da jede radnik u Mercedesu kad uveče dođe kući .. biću iskren, naravno da ne znam šta je "market cap" zamišljam ga kao neki ekonomski berzanski parametar koji se računa kao uzmi, smuti, prospi, pomnoži, podeli, dodaj lepe želje i eto .. jer bi inače bilo nvidia ima toliko na računu, bmw ima toliko, i onda ovi kupe ove ili obrnuto.

[ djoka_l @ 08.06.2024. 14:41 ] @

Market Cap (market capitalization) ili tržišna kapitalizacija je "vrednost" kompanije na berzi. Jednostavno to je broj akcija puta vrednost akcije. Nikakva složena matemtaika, proizvod dva broja.

[ MajorFatal @ 08.06.2024. 15:06 ] @

Paa.. nikakva složena matematika za nekog ko zna brojeve i matematiku, ali za mene šta znam, već mi sumnjivo na prvom koraku, u pitanju je "broj akcija" onda nije isto ako firma izda 1000 akcija, i ako objavi 100.000 akcija i ako akcije prve vrede 1000$ a ove druge 1$, ispada da ima je market cap isti, ali meni ne deluje da su to iste ili slične firme ..

Svejedno da bi kupili celu nečiju auto industriju morali bi prvo da prodaju akcije, da bi uzeli lovu sa kojom da kupe, ali onda mora da postoji neko sa lovom, a da nema njihove akcije, i po mogućstvu da nije vlasnik auto industrije, da bi kupio od njih, pa tek onda da kupuju akcije auto industrije, ali onda nisu vlasnici ni svog biznisa, sve u svemu komplikovano, a nit ovi kupuju njihove, nit ovi njihove, pa smatram da to ne ide tako lako, nego samo na papiru.

[ djoka_l @ 08.06.2024. 23:05 ] @

Nema veze po kojoj ceni su akcije nekada u prošlosti prodate.

Akcije su "sličice".

Firma je emitovala milion sličica. Cena na berzi za svaku sličicu je 2 (na primer) po današnjem stanju berze.

Market cap je 1,000,000 * 2 = 2 miliona novčanih jedinica.

Sutra je cena na berzi 3, onda je sutra market cap 3 miliona.

[ MajorFatal @ 09.06.2024. 22:07 ] @

Dobro, ali zašto ta ista firma nije umesto milion emitovala 1000 sličica, sa cenom na berzi po 2000 svaka opet bi market cap bio 2 miliona novčanih jedinica, a sutra cena na berzi 3000 onda sutra market cap 3 miliona, sve isto .. ali bi mogli da se hvale među drugim firmama: Vidi ova naša jedna akcija 3000$ a vidi one tamo bednike akcija im 3$, a u stvari market cap im isti, isto vrede.

[ Ivan Dimkovic @ 10.06.2024. 08:08 ] @

Monetarna (trenutna) vrednost akcije je besmislen podatak bez ukupnog broja akcija (sto ti daje market cap) i fundamentalnih parametara poslovanja firme.

Mozes ti da emitujes koliko hoces akcija ali vrednost tvoje firme utvrdjuje trziste na osnovu pomenutih fundamentalnih parametara i prognoza kuda idu trziste i tvoja firma u njemu, pa bi se na bilo koju vrednost i broj akcija brojevi nivelisali na ocekivanje trzista u odnosu na realnost. Samu vrednost akcija odredjujes ne ti kao emiter, vec samo oni koji akcije kupuju i prodaju.

TL;DR - vredis koliko su drugi spremni da plate.

Kao firma, emitovanjem svojih akcija bez da se ista promeni umanjujes njihovu vrednost, dok kupovinom svojih akcija bez da se ista drugo menja im povecavas vrednost (neke firme to rade - vidi 'stock buyback', to je nesto sto je nekim firmama u USA strategija umesto isplate dividendi zato sto je poreski trenutno efikasnija).

[ djoka_l @ 10.06.2024. 11:58 ] @

Citat: MajorFatal:

Dobro, ali zašto ta ista firma nije umesto milion emitovala 1000 sličica, sa cenom na berzi po 2000 svaka opet bi market cap bio 2 miliona novčanih jedinica, a sutra cena na berzi 3000 onda sutra market cap 3 miliona, sve isto .. ali bi mogli da se hvale među drugim firmama: Vidi ova naša jedna akcija 3000$ a vidi one tamo bednike akcija im 3$, a u stvari market cap im isti, isto vrede.

Zašto postavljaš besmislena pitanja?

Da li je veći baja onaj milioner koji ima milion novčanica od 1 dolar ili onaj koji ima 10 hiljada od 100 dolara?

Cena akcije je potpuno nebitna, osim kao faktor koji se koristi da se pomnoži sa brojem akcija.

Osim toga, inicijalnu cenu pojedinačne akcije određuje firma koja izlazi na berzu, kasnije kretanje cene akcije diktira ponuda i potražnja na berzi.

Inicijalna cena je "vrednost apoena". Ima puno razloga da inicijalna cena bude mala, recimo 10 ili 100 jedinica.

Ako si ti mali akcionar i kupuješ akcije kao vid štednje, možda nemaš 1000 dolara da kupiš akciju od 1000 dolara, nego si uštedeo 500 dolara, pa možeš da kupiš 50 akcija koje pojedinačno vrede po 10 dolara.

Za velike investitore je potpuno nebitno koliko košta pojedinačna akcija, ali je za male bitno.

[ Ivan Dimkovic @ 10.06.2024. 13:50 ] @

Obicno firme cija vrednost akcija naraste puno urade 'split' tj. za svakih X akcija emituju jos Y, kako bi cena pojedinacne akcije ponovo postala OK za male investitore - sto djoka_l rece, za one koji kupuju akcije kao vid stednje, za velike investitore je nebitno koliko jedinica akcija vredi, ono sto je bitno je da li fundamentalni parametri firme jesu u saglasnosti sa investicionom strategijom.

NVIDIA je upravo uradila 10:1 split i jedna akcija od $1208.88 je postala 10 akcija od $120.88 - sustinski se nista nije promenilo, svako ko je imao N akcija NVIDIA-e sada ima 10*N akcija. Vrednost firme je ostala ista.

Berza je samo nacin da se brze dodje do razmene izmedju ljudi koji poseduju kapital i ljudi koji poseduju udeo u vlasnistvu firme. Sto se same vrednosti firme tice, fundamentalno nista nije razlicito izmedju firmi van berze i firmi koje se trguju na berzi. "Market cap" tj. trzisna vrednost firme na berzi zavisi od istih faktora od kojih zavisi i vrednost firme koja nije na berzi, jedino je lakse doci do vlasnistva dela firme koja je na berzi, zato sto je to moguce svakom ko ima novca i ko ima pristup trading platformama.

[ sikira069 @ 10.06.2024. 14:09 ] @

I sutra će akcije otići + ili -.

Klasična kocka.

Berza uzima istu proviziju akcionarima kao i Mozzart kladionica igračima.

Ne vidim razliku.

Ovamo se kladiš na Nvidiu, a u Mozzartu na Real.

[ djoka_l @ 10.06.2024. 14:34 ] @

Ne vidiš razliku?

Možeš da kupiš plac, a država uzme proviziju (porez). A cena placa može da ode + ili -

Da li je to isto kao kladionica?

Ili ni tu ne vidiš razliku?

[ sikira069 @ 10.06.2024. 16:34 ] @

Za plac vidim razliku. Kupuje se da bi napravio kuću i tu živeo. Neophodnost.

Berza je kockanje.

Zarađuju samo organizatori.

[ Ivan Dimkovic @ 10.06.2024. 17:54 ] @

Kockarima je sve kocka i logicno je da ne vide razliku posto im je mozak nabazdaren da u svemu vide nacin da ispolje sopstvene defekte.

Hint: vecina vlasnika akcija se ne kockaju sa njima vec zaradjuju ili na dividendama ili na rastu akcija na duzi rok.

Citat:

Za plac vidim razliku. Kupuje se da bi napravio kuću i tu živeo. Neophodnost.

Najveci vlasnici akcija su penzioni fondovi kao i uzajamni fondovi u kojima ljudi parkiraju lovu i stite je od inflacije. Niko se tu ne kocka vec je berza jedan od stubova njihovih investicionih strategija i trivijalno je videti da najvise zaradjuju upravo oni sto je potpuno suprotno od tvrdnje da "zaradjuju samo brokeri". Parkirati deo slobodne love na 5-10-15 godina u blue-chip akcije na berzi je pametna stvar i nema nikakve veze sa kockom vec je zdrav razum.

Kockari od svega naprave kocku, akcije su samo jedan od bezbroj nacina da ispoljavaju svoju zavisnost. Da, na njima najvise zaradjuju brokeri - sto ne bi, dok je curana bice i podvarka. [ sikira069 @ 10.06.2024. 18:24 ] @

Jedino sigurno je dati u Poštansku štedionicu na skoro 3% godišnje kamate koliko je bilo u martu na devizne uloge.

Ne verujem da te blue-chip akcije stalno rastu.

Nekada i padaju. To chip je baš pokeraški izraz.

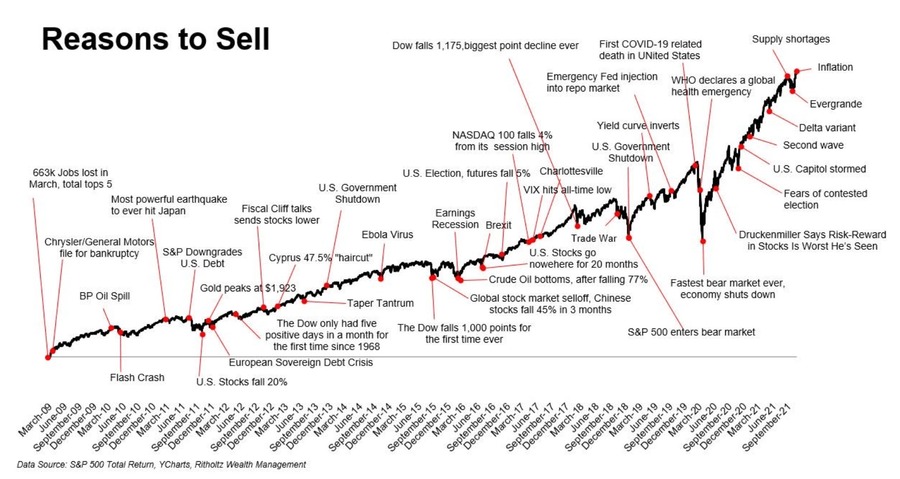

[ Nebojsa Milanovic @ 10.06.2024. 18:41 ] @

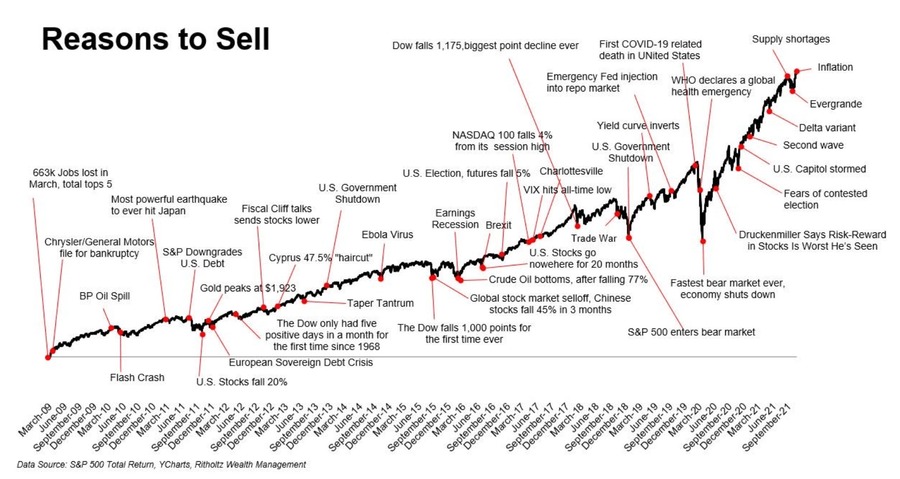

Citat: sikira069:Ne verujem da te blue-chip akcije stalno rastu. Niko nije rekao da akcije stalno rastu.

Često i padaju, i to veoma jako, imali smo prilike samo u poslednjih par godina da to vidimo XXX puta.

No, osim što pričaš isto kao većina totalno neobrazovanih ljudi i predstavljaš najgore od njih, prosečan Srbin, iako često glup, nije tako pokvaren kao ti, da toliko uporno da ruši svaku smislenu diskusiju na ES-u.

Za one koji žele ovde nešto smisleno da čuju, evo dva dijagrama da uvek postoje "pametni razlozi" za prodaju akcija i izlazak sa USA berze.

[/url]

Zaradio je ogroman bolji ljudi, u periodu 2015-2020 recimo naročito, posebno 2017. kada je bilo nemoguće izgubiti.

Međutim, sada kada je USA hegemonija konačno na izdahu, kada im se toliko štampanje para obija o glavu, kada gube rat "koji ne smeju da izgube" - sada se ZAISTA postavlja pitanje da li sa ovih nivoa američka berza može gore (o evropskim akcijama niko i ne razmišlja) - ili će balon konačno puknuti i sve se raspasti.

Neće trebati dugo vremena da to vidimo i sami. [ Ivan Dimkovic @ 11.06.2024. 14:07 ] @

Citat: sikira069:

Jedino sigurno je dati u Poštansku štedionicu na skoro 3% godišnje kamate koliko je bilo u martu na devizne uloge.

Ne verujem da te blue-chip akcije stalno rastu.

Nekada i padaju. To chip je baš pokeraški izraz.

Nema nicega pokeraskog parkiranjem novca u neki mutual fond koji prati NASDAQ ili NYSE, ili uraditi to isto sam investiranjem u portfolio akcija pojedinacnih firmi. Ljudi parkiraju svoje pare na 5-10+ godina i generalno ce proci bolje nego da su ih stavili u banku nisu nikakvi kockari vec racionalne individue koje pametnu raspolazu svojim novcem.

Potpuno je irelevantno to sto pojedinacne akcije skacu i padaju svakog dana ako je strategija dugorocna a ne kockanje. Ako mogu da zaboravim na taj novac u sledecih 10 ili 15 godina, sto bi me bila briga sto iz dana u dan vrednost akcija fluktuira? Ideja je upravo da ne razmisljas o tome - cista antiteza kockanju.

Sto se tice ocuvanja vrednosti investicija, nema nicega apsolutno sigurnog - to sto dobijas od banke na stednju moze biti manje od realne stope inflacije i na kraju ostajes sa manjom kupovnom moci nego kada si poceo. Ulaganje u benchmark akcije kao dugorocna strategija je nesto malo vise rizicno od stednje u banci zato sto moze da se desi da ako ti novac hitno treba da u tom momentu vrednost bude manja ali je taj rizik kompenzovan sa dobitkom koji je veci od stope inflacije i koji je sigurniji koliko duze taj novac drzis parkiran.

Ko ima toleranciju na rizik od 0% nece ulagati u bilo kakvu vrstu spekulativne investicije, ali je besmisleno nazivati dugorocno ulaganje u berzu kockanjem. [ Nebojsa Milanovic @ 11.06.2024. 15:39 ] @

@Ivan

Lepo si napisao ali nemoj reći da si mislio da sikira to ozbiljno piše.

Od prvog dana, na oba nicka, cilj mu je isključivo da sruši svaki smislenu diskusiju na ES-u, i na moje zgražavanje, u tome je i uspeo.

Konačno je banovan ali kasno, prekasno, sada kada je uništio svaki smisao konstruktivne priče.

Apsolutno najgora stvar na ES-u je dozvoljavanje trolovima da namerno ruše konstruktivne diskusije.

Toga je ranije bilo više, ali postojao je jedan period čist od toga, do pojave sikire, kome se nije smelo dozvoliti da toliku štetu napravi.

[ MajorFatal @ 11.06.2024. 20:16 ] @

Citat: Ivan Dimkovic:

Monetarna (trenutna) vrednost akcije je besmislen podatak bez ukupnog broja akcija (sto ti daje market cap) i fundamentalnih parametara poslovanja firme.

Pretpostavljam da svaki podatak može da bude besmislen kad je istrgnut iz konteksta. Vrednost akcije naravno da je bitan i smislen podatak za onog ko tu akciju hoće da kupi ..

Citat: Mozes ti da emitujes koliko hoces akcija ali vrednost tvoje firme utvrdjuje trziste na osnovu pomenutih fundamentalnih parametara i prognoza kuda idu trziste i tvoja firma u njemu, pa bi se na bilo koju vrednost i broj akcija brojevi nivelisali na ocekivanje trzista u odnosu na realnost. Samu vrednost akcija odredjujes ne ti kao emiter, vec samo oni koji akcije kupuju i prodaju.

Pa dobro, na koji način se firme odlučuju za emitovanje kojeg broja akcija, jer je prilično očigledno da ako emituješ veći broj akcija manje će vredeti pojedinačna i obrnuto.

Citat: TL;DR - vredis koliko su drugi spremni da plate.

Zanima koliko se vrednost neke firme poklapa sa platežnom moći te firme? Razgovor je počeo od toga da nvidia može da kupi auto industriju, a ja i dalje mislim da ne može, iako je na papiru vrednija .. ako su akcionari nvidije vlasnici biznisa možda oni mogu da kupe auto industriju? A to baš nije isto kao da je nvidija kupila? Evo ne znam sve mi zbrčkano.

Citat: Kao firma, emitovanjem svojih akcija bez da se ista promeni umanjujes njihovu vrednost, dok kupovinom svojih akcija bez da se ista drugo menja im povecavas vrednost (neke firme to rade - vidi 'stock buyback', to je nesto sto je nekim firmama u USA strategija umesto isplate dividendi zato sto je poreski trenutno efikasnija).

Verovatno emitovanjem *dodatnih akcija. Spekulacija, vrednost firme na berzi možda ne govori mnogo o platežnoj moći.

[ MajorFatal @ 11.06.2024. 20:26 ] @

Citat: djoka_l:

Zašto postavljaš besmislena pitanja?

Zar nisi čuo da ne postoje besmislena pitanja, samo besmisleni odgovori.. ? :)

Citat: Da li je veći baja onaj milioner koji ima milion novčanica od 1 dolar ili onaj koji ima 10 hiljada od 100 dolara?

Isti su, ali moje pitanje nije bilo u tom smislu, nego više da li je bolje izaći iz kuće sa buđelarom punim sitnih apoena, ili sa dve - tri krupne novčanice, to je i dalje isto dok se ne ispostavi da ideš na svadbu, ili u kupovinu auta, baje su iste, ali bi bio manji baja ako krene sa sitnim apoenima u kupovinu auta jer bi mu trebao ceo šleper, slično bio bi manji sa dve tri krupne novčanice na svadbi jer bi brzo sve dao na muziku, pa ne bi imao za mladence, konobare, fotografije ..

Citat: Cena akcije je potpuno nebitna, osim kao faktor koji se koristi da se pomnoži sa brojem akcija.

Bukvalno dva reda niže ti sam pišeš da je cena akcija ipak bitna kad su mali akcionari u pitanju, da ne boldujem.

Citat: Osim toga, inicijalnu cenu pojedinačne akcije određuje firma koja izlazi na berzu, kasnije kretanje cene akcije diktira ponuda i potražnja na berzi.

Zašto bi se ponuda i potražnja ikad menjale ako je biznis stabilan i višedecenijski?

Citat: Inicijalna cena je "vrednost apoena". Ima puno razloga da inicijalna cena bude mala, recimo 10 ili 100 jedinica.

Ako si ti mali akcionar i kupuješ akcije kao vid štednje, možda nemaš 1000 dolara da kupiš akciju od 1000 dolara, nego si uštedeo 500 dolara, pa možeš da kupiš 50 akcija koje pojedinačno vrede po 10 dolara.

Za velike investitore je potpuno nebitno koliko košta pojedinačna akcija, ali je za male bitno.

Bukvalno par redova iznad ti sam pišeš da je cena akcija totalno nebitna, osim da se pomnoži sa brojem akcija, tako da dogovori se pa kaži, da li je cena bitna ili nije?

[ Nebojsa Milanovic @ 11.06.2024. 21:25 ] @

@Major

Sve što si pitao je toliko bizarno-besmisleno da nije jasno da li stvarno toliko ne znaš, ili želiš da saznaš - ili samo troluješ.

Cena SVIH akcija na svetu zavisi PRVENSTVENO od makro-okruženja, kamatnih stopa i XXX drugih parametara, pa tek onda od stabilnosti biznisa, koji naravno mora da se podrazumeva (u suprotnosti je bankrot).

Evo ti primer firme koju svi znamo, Pejpal, ticker: PYPL.

Pogledaj koliko stabilno rastu i prihodi i poslovanje firme - a koliko cena akcije NEME VEZE sa tim.

Uzmi u obzir da je to oooogromna firma vredna 100+ milijardi dolara.

Kod manjih firmi sve to je još daleeeeko izraženije. [ Shadowed @ 11.06.2024. 22:18 ] @

Citat: MajorFatal: Zar nisi čuo da ne postoje besmislena pitanja, samo besmisleni odgovori.. ? :)

Tu mantru ponavljaju oni koji postavljaju besmislena pitanja sto ne znaci da je tacna. [ MajorFatal @ 11.06.2024. 22:31 ] @

Tu "mantru" sam malopre izmislio, tako da teško da se ponavljala, mantra je da ne postoje glupa pitanja, to se često moglo čuti ..

Ne znači da je tačna, ali takođe nikog ne obavezuje da odgovara na glupa ili besmislena pitanja, samo preskoči što bi rekli ..

U konkretnom slučaju, konstatacija da je pitanje besmisleno je pokušaj uvrede, sa ciljem diskreditacije sagovornika, iz razloga nemanja argumenata ili neznanja da se odgovori na savršeno smisleno pitanje.

[ Shadowed @ 12.06.2024. 08:04 ] @

Ponavljaju i za besmislena i za glupa. To sto si ti sad nesto "izmislio", ne znaci da si prvi.

Kada postavis besmisleno pitanje konstatacija da je besmisleno nema nikakave veze sa diskreditovanjem, sam si se diskreditovao.

Inace je minimum 90% tvojih bilo pitanja bilo izjava i besmisleno i glupo. Nije problem ne odgovarati (kao sto ti najcesce i ne odgovaram sto i drugima preporucujem). Problem je u bacenom vremenu na citanje istih.

[ MajorFatal @ 12.06.2024. 08:39 ] @

Citat: Shadowed: Ponavljaju i za besmislena i za glupa. To sto si ti sad nesto "izmislio", ne znaci da si prvi.

Ne ponavljaju, "nema glupih pitanja već ...itd" koriste pedagozi da ponutkaju i oslobode decu da postavljaju pitanja. "Nema besmislenih pitanja.." nikad ranije nisam čuo, ali nisam tvrdio ni da sam "prvi".

Citat: Kada postavis besmisleno pitanje konstatacija da je besmisleno nema nikakave veze sa diskreditovanjem, sam si se diskreditovao.

Nije "kada", nego "ako". Ako postavim besmisleno pitanje zaista je tako kako ti kažeš, ali ako ne postavim onda nije.

Citat: Inace je minimum 90% tvojih bilo pitanja bilo izjava i besmisleno i glupo. Nije problem ne odgovarati (kao sto ti najcesce i ne odgovaram sto i drugima preporucujem). Problem je u bacenom vremenu na citanje istih.

Fala ti za te lepe reči i procenu. Moram priznati da bi mogao biti problem ako tako procenjuješ. Imao sam i ja par njih za koje mi se činilo da je 90% onog što pišu upitnog kvaliteta, nije bilo lako ali uspeo sam da se istreniram da njihove postove jednostavno ne čitam. Zar ti nisi imao neku skriptu za ignorisanje korisnika? Ali ako bi je koristio onda nedostaje kontekst, ako se desi da neko odgovara baš na moju repliku. Jedino još mogu da ti ponudim da odsustvujem sa foruma, ako će ti to uštedeti dragoceno vreme? [ miki069 @ 20.07.2024. 18:21 ] @

Što pada vrednost akcija NVIDIA?

Za 10 dana su sa 135 pale na 118.

Jel ovo dobar trenutak za kupovinu?

[Ovu poruku je menjao miki069 dana 20.07.2024. u 20:56 GMT+1]

[ miki069 @ 27.07.2024. 23:31 ] @

NVIDIA nastavlja pad.

Akcije pale na 113 dolara.

Pre 15 dana su bile 135 dolara.

[ Nebojsa Milanovic @ 28.07.2024. 03:38 ] @

[ miki069 @ 28.07.2024. 14:45 ] @

I akcije AWS su za 15 dana pale sa 200 dolara na 180 dolara.

[ Nebojsa Milanovic @ 28.07.2024. 17:57 ] @

Nije to AWS nego Amazon

Pao je i on zbog jake korekcije na marketu poslednjih dana, a poenta mog posta je da će Nvidia u skorije vreme osetiti konkurenciju koju do sada nije imala. [ miki069 @ 28.07.2024. 19:02 ] @

Amazon Web Services (skraćeno, AWS).

[ Nebojsa Milanovic @ 28.07.2024. 22:38 ] @

Haaalo, AWS je deo Amazona i nije izlistan na berzi  [ miki069 @ 29.07.2024. 14:35 ] @

Što se tiče akcija izgleda da je mnogo bitna ona poslovica da ne kune majka sina kada ide da se kocka, već ga kune kada ide da se vadi.

Klasično kockanje u kome samo brokeri zarađuju.

Obični ljudi samo gube.

[ miki069 @ 30.07.2024. 15:30 ] @

NVIDIA nastavlja pad.

Akcije pale na 107.4 dolara.

[ Nebojsa Milanovic @ 30.07.2024. 15:36 ] @

Paper hands paniče i prodaju - pametni se tovare. Uvek bilo.

[ djoka_l @ 30.07.2024. 15:42 ] @

Akcije NVIDIA su naduvane.

Ceo AI balon se pomalo izduvava, ali NVIDIA je mnooogo dobra kompanija.

Prave nenormalan profit, tako da ovo više liči na pad na realnu vrednost nego što predstavlja stvarni problem kompanije.

[ miki069 @ 30.07.2024. 17:40 ] @

Nvidia akcije padaju svake sekunde.

Sada su 104.3 dolara.

Ništa od akceleratora? Blue-chip?

Market chap?

Sve prenaduvano i nerealno.

Treba imati m.da pa kupiti.

Što reče Đole "povukao je damu na 18 mrtav ladan...".

[ miki069 @ 31.07.2024. 13:44 ] @

Opet pada vrednost akcija.

Sada je 103.7 $.

[ miki069 @ 31.07.2024. 18:25 ] @

Sada su akcije porasle na 115.8 $.

[ miki069 @ 31.07.2024. 22:33 ] @

Opet rast na 116.95 $.

Sutra počinje retrogradni Merkur.

Najverovatnije akcije idu dole.

[ Nebojsa Milanovic @ 01.08.2024. 01:25 ] @

Večeras u after hours trgovanju cena NVDA akcija je 122 dolara.

Šta sam rekao:

Citat: Nebojsa Milanovic: Paper hands paniče i prodaju - pametni se tovare. Uvek bilo. Tačno to.

Takođe i sa CRWD akcijama je bilo tačno onako kako sam rekao, sutra ću napisati. [ miki069 @ 01.08.2024. 17:15 ] @

Retrogradni Merkur čini svoje.

Akcije pale na 113.42 $.

Može još gore.

Palo na 108.4 $.

[Ovu poruku je menjao miki069 dana 01.08.2024. u 20:45 GMT+1]

[ Nebojsa Milanovic @ 01.08.2024. 21:17 ] @

To je zbog veoma oštrog pada celog marketa, pojava nema veze sa NVDA akcijama.

Oporaviće se.

[ Nebojsa Milanovic @ 02.08.2024. 00:40 ] @

Citat: Nvidia, $NVDA, the third largest company in the world is trading like a penny stock.

Since its after hours low seen just 18 hours ago, Nvidia has added $380 BILLION of market cap.

In other words, Nvidia has added as much market cap as the entire value of Costco, $COST, in 18 hours.

This comes after the stock erased $1 TRILLION of market cap over the last 5 weeks.

Big tech stocks are throwing around trillions of Dollars of market cap in a matter of hours.

Truly insane.  [ Nebojsa Milanovic @ 02.08.2024. 00:54 ] @

Citat: Yesterday, Nvidia, $NVDA, broke the all time record for most market cap added by a stock in a single day, adding +$330 billion.

Today, the stock has erased ~$270 billion of market cap since its high seen this morning.

That's a $600 BILLION swing in market cap in just 2 trading days.

The 3rd largest public company in the world is officially trading like a meme stock.  [ Nebojsa Milanovic @ 02.08.2024. 22:37 ] @

Citat: Nebojsa Milanovic:

To je zbog veoma oštrog pada celog marketa, pojava nema veze sa NVDA akcijama.

Oporaviće se. Ovo sam rekao odmah, a evo sada i dokaza:

https://x.com/RadarHits/status/1819396774211338350/photo/1[ miki069 @ 03.08.2024. 12:51 ] @

Trenutna vrednost akcije je 107 $.

Pre 20 dana je akcija vredela 135 $.

Ne razumem šta se tu oporavilo?

Ko je tada kupio akcije izgubio je preko 20%.

[ mpman @ 04.08.2024. 11:25 ] @

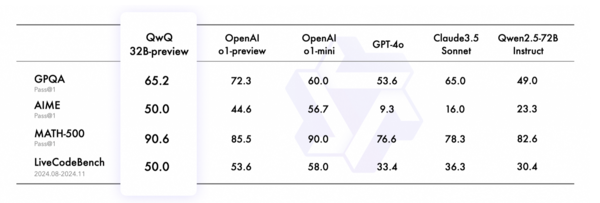

Trenutno mi se čini da ono što se naziva danas veštačkom inteligencijom nije ono za šta se predstavlja. U pitanju su samo veliki, specijalizovani modeli mašinskog učenja sa ogromnim bazama podataka. Ako sam dobro razumeo kako sve to funkcioniše, mašinsko učenje se na neki način oslanja na metaheuristiku i evolucione optimizacione algoritme pri čemu se nalazi način da se kvantifikuje određena specijalizovana stvar na osnovu koje se definišu težinski koeficijenti koji se minimizuju kroz niz iteracija dok se ne iscrpi početna baza podataka, pa se ti isti težinski koeficijenti primenjuju nad novim modelima.

Ovo je problem i ovo nije u suštini veštačka inteligencija u smislu u kojem mi mislimo da jeste. Jer ekstrapolacija podataka ne mora nužno da bude uspešna nezavisno od toga na čemu je model treniran, što znači da je jošuvek ljudska intervencija neophodna. Trenutno stanje veštačke inteligencije je da ona ne može da smisli ništa novo, već kombinuje stvari na osnovu već postojećih primera. Ona ne razume šta radi, o čemu piše, šta slika, već na osnovu kaznenih funkcija koje negativno utiču na minimizaciju težinskih koeficijenata i konačne funkcije cilja dolazi do određenih rezultata. To znači da ona suštinski ne može da uvidi nove šablone i kreira nove stvari, već može samo da radi sa onim na čemu je model treniran.

That being said... Veliki broj poslova upravo to i zahteva. Kombinovanje postojećih rešenja da bi se nešto rešilo, napisalo, nacrtalo. Takvi poslovi su sada ugroženi, ali opet oni koji znaju šta rade i koji su dobri u svom poslu ostaće da "hrane" i kontrolišu algoritam. Što se autonomne vožnje tiče, osim dobrog marketinga koji je gospodin Mask odradio, od toga nema ništa. Jer je vožnja jedan od onih slučajeva gde greške u ekstrapolaciji mogu biti pogubne. Ona može biti dovoljno dobra u 80% slučajeva, ali u 20% slučajeva će koštati života. Jer vožnja je jedan od onih stvari u kojoj će se uvek javljati pojave koje niko nije mogao da predvidi u datim okolnostima.

Ono što je strašno i što je opasno jeste to što se ljudi opuštaju. Volan u novim vozilima nema vizičku konekciju sa točkovima. Automobili su visoko uvezani tehnološki sistemi koji mogu da komuniciraju jedni s drugima. Do sada je bilo x skandala gde su već sadašnji automobili špijunirali svoje korisnike, a automobilske kompanije su prodavale podatke o tome gde su njihovi korisnici vozili, kada, kako i koliko osiguravajućim kućama koje su posle na osnovu toga podizale premiju za osiguranje automobila. Osim ogromne invazije privatnosti, zamislite koliko će lako biti rešiti se političkih protivnika zbog "baga u sistemu" ili "loše procene veštačke inteligencije".

[ miki069 @ 04.08.2024. 12:08 ] @

Što se Matematike tiče ne vidim neki pomak.

Sve što može brute-force je davno isprogramirano.

Gde god mora da se bude kreativan nema pomoći od računara.

O tome da će zameniti profesora tek nema šanse.

[ mpman @ 04.08.2024. 12:24 ] @

I što se tiče upravljanja... Većina stvari koje se brendiraju u poslenje vreme kao "VI" su zapravo samo sistemi automatskog upravljanja sa direktnom kompenzacijom poremećaja, tema razrađena kod nas još osamdesetih, u svetu i ranije. Razlika je samo u tome što se mehaničke komponente menjaju elektronskim, a komunikacija sa sistemima se odvija na daljinu. Mada, složićete se, nije neka razlika.

[ B3R1 @ 04.08.2024. 13:44 ] @

Citat: mpman:

Trenutno mi se čini da ono što se naziva danas veštačkom inteligencijom nije ono za šta se predstavlja.

Zavisi koga pitas. Ako citas clanke koje su pisali likovi koji zavrse smer zurnalistike na onom smehotresnom fakultetu na Vozdovcu ... ili na nekome jos smehotresnijem privatnom fakultetu - onda je odgovor: da, to svakako nije ono kako mali Perica (to jest taj jadnicak od "studenta") shvata AI.

Citat: U pitanju su samo veliki, specijalizovani modeli mašinskog učenja sa ogromnim bazama podataka. Ako sam dobro razumeo kako sve to funkcioniše, mašinsko učenje se na neki način oslanja na metaheuristiku i evolucione optimizacione algoritme pri čemu se nalazi način da se kvantifikuje određena specijalizovana stvar na osnovu koje se definišu težinski koeficijenti koji se minimizuju kroz niz iteracija dok se ne iscrpi početna baza podataka, pa se ti isti težinski koeficijenti primenjuju nad novim modelima.

Bravo! Ovo si bas lepo sazeo u jednu recenicu. To funkcionise bas tako.

Takodje, masinsko ucenje nije nova stvar. Nekolicina mojih kolega su jos pre 25 godina doktorirali na temu primene masinskog ucenja u raznim oblastima i u to vreme ti doktorati su bili hit. Ljudi su te PhD radili mahom u Americi, ali bilo je i onih koji su to odradil iu Srbiji. Ono sto jeste novo je LLM - odnosno slozeni modeli govornog jezika. Takva stvar nije bila moguca pre 25 godina iz prostog razloga sto u to vreme nismo imali dovoljno mocan hardver na kome bi se to vrtelo. LLM modeli su gradjeni decenijama, a ovo sto vidis danas je samo rezultat svih tih istrazivanja koja su radjena do sada.

Problem je u tome sto ljudi postavljaju znak jednakosti iza jedne siroke naucno-tehnoloske oblasti zvane vestacka inteligencija (AI / VI), masinskog ucenja, neuralnih mreza i LLM, a sva ta 4 pojma, iako srodna medju sobom, su ipak totalno odvojene stvari. Bas kao sto je velika vecina ljudi (cak i strucnjaka) 90-ih pogresno stavljala znak jednakosti izmedju Interneta i Weba, a danas to rade isto s drustvenim medijima i drustvenim mrezama ... pa kada npr. Instagram ne radi zbog nekog tehnickog problema u mrezi Meta, na medijskim portalima se pojave naslovi tipa: "Pao Internet". Ljudi, nije pao Internet, on je jos uvek zivahan i koristim ga upravo ... a to sto vi ne mozete da lajkujete gluposti, to je vas problem.

Ali objasni ti to skolarcima smehotresne novinarske skolice s Vozdovca ... doduse, njima svaki dan "Internet gori od Severiniih slika s plaze" ... a "Djokovic je zagrmeo". Internet ne gori, nije zapaljiv. Ljudi ne grme. Naucite vec jednom !!! :-)))

Citat: Trenutno stanje veštačke inteligencije je da ona ne može da smisli ništa novo, već kombinuje stvari na osnovu već postojećih primera.

Tako je.

Citat: Veliki broj poslova upravo to i zahteva.

Nazalost, i to je tacno. U vecini velikih korporacija na zapadu mnogi ljudi rade bas takve stvari - npr. na osnovu nekih brojeva (najcesce finansijskih rezultata, ali i drugih KPI) u Excelu on pise izvestaj za svoje menadzere, a kada mu menadzeri sugerisu sta treba uraditi on pise detaljna uputstva svojim podredjenima. Drugim recima, izigrava protocni bojler. Cim vidis firmu u kojoj imas npr. 9 nivoa menadzera od krajnjeg izvrsioca do CEO znaj da barem cetvoro u tom lancu radi najobicniji I/O, bez grama mozga. Ameri to zovu paper-pushers. I sto je najgore, ti poslovi su neretko izuzetno dobro placeni!

Citat: Takvi poslovi su sada ugroženi

Nisu. Samo ce morati mnogo vise da rade. Koriscenjem AI, naravno. I umesto aktivne uloge u stvaranju necega dobice pasivnu ulogu kontrologa tog necega sto je AI napravila. Problem ce nastati onda kada se od njih bude zahtevalo da umesto npr. 3-4 projekta nedeljno sada rade na 30-40, a mozda i na 300-400 istovremeno. Jer tu je AI. Bas kao sto se nekada ocekivalo da jedan projekat od nekih ~100 stranica teksta drukas na nekoj raspaloj pisacoj masini nedeljama, a mozda i mesecima i radis taj jedan ... dok danas uzmes ono sto su ti radile kolege, copy/paste - pljas, gotovo, sledeci ... i to je normalno, reuse - recycle ... I to je danas moguce zahvaljujuci Wordu i njegovom <Ctrl-C><Ctrl-V>.

Sutra ce se zahtevati mnogo vise, jer ce cukanje teksta u Wordu zameniti autogenerisanje dokumenta AI-em.

Citat: Osim ogromne invazije privatnosti, zamislite koliko će lako biti rešiti se političkih protivnika zbog "baga u sistemu" ili "loše procene veštačke inteligencije".

Ne znam za politiku, time se ne bavim. Ali znam za su mnoge kompanije pocele da koriste AI u procesu zaposljavanja novih radnika, tako da neko ko je mozda izuzetno iskusan u svom poslu, a u CV nema naglasene kljucne reci na koje je AI softver istreniran, nece proci prvi filter i njegov CV nece ni stici do hiring menadzera. Ali ni radnici nisu nista bolji. Poceli su da koriste AI za pisanje CV i sada svi CV-evi lice jedan na drugi. :-)

Medjutim, ima jedna stvar u kojoj AI nece moci da zameni ljude jos prilicno dugo.

Na departmanu Telekomunikacija lozanskog fakulteta EPFL pre 50 godina predavao je izvesni profesor Juillard. U predgovoru svog udzbenika profesor je napisao sledece reci:

Citat: L’ingénieur est un type qui sait ce qu’il peut négliger

U prevodu: inzenjer je lik koji zna sta se moze zanemariti

U knjizi potom sledi prelep predgovor, za koji bih vam savetovao da ga procitate, ako treba koristite i Google Translate. Uvek se odusevljavam iznova kada procitam taj tekst. Pritom, stari profesor nije bas bio 100% originalan i verovatno je bio inspirisan svojim zemljakom, autorom Malog princa, koji je rekao nesto slicno - da se perfekcija ne postize onda kada nemas vise sta da dodas, vec kada vise nemas sta da oduzmes.

I mislim da je upravo ta vestina zanemarivanja, odnosno aproksimacije ono sto ce nas sigurno jos dugo razlikovati od masine. [ mpman @ 04.08.2024. 16:43 ] @

Citat: Nisu. Samo ce morati mnogo vise da rade. Koriscenjem AI, naravno. I umesto aktivne uloge u stvaranju necega dobice pasivnu ulogu kontrologa tog necega sto je AI napravila. Problem ce nastati onda kada se od njih bude zahtevalo da umesto npr. 3-4 projekta nedeljno sada rade na 30-40, a mozda i na 300-400 istovremeno. Jer tu je AI. Bas kao sto se nekada ocekivalo da jedan projekat od nekih ~100 stranica teksta drukas na nekoj raspaloj pisacoj masini nedeljama, a mozda i mesecima i radis taj jedan ... dok danas uzmes ono sto su ti radile kolege, copy/paste - pljas, gotovo, sledeci ... i to je normalno, reuse - recycle ... I to je danas moguce zahvaljujuci Wordu i njegovom <Ctrl-C><Ctrl-V>.

Sutra ce se zahtevati mnogo vise, jer ce cukanje teksta u Wordu zameniti autogenerisanje dokumenta AI-em.

Skoro je bilo velikih otpuštanja u određenim novinarskim firmama gde su radnici zamenjeni LLM-om, tj. OpenAI-jem ko god da je nalepio svoj brend preko toga. Na to sam mislio kad sam rekao da su ti poslovi sada ugroženi. Čim se poveća "produktivnost" "novinara" umanjuje se potreba za dodatnim "novinarima". Ako je cilj 600 članaka mesečno, lupam, i za to je bez upotrebe ovih tehnologija potrebno, opet lupam, 60 ljudi... Ako tu mesečnu kvotu uz korišćenje tehnologija može da ispuni 20 ljudi, to znači da je 40 ljudi višak, tj. dobijaju otkaz. Ne kažem da će se radna mesta ugasiti, već će biti potrebno manje ljudi.

Oko ostalog se slažemo. Jako lep citat i predgovor :)

[ Nebojsa Milanovic @ 04.08.2024. 23:38 ] @

Citat: miki069:

Trenutna vrednost akcije je 107 $.

Pre 20 dana je akcija vredela 135 $.

Ne razumem šta se tu oporavilo?

Ko je tada kupio akcije izgubio je preko 20%.

Aham..poenta je u tome što niko normalan tu akciju ne kupuje na All-time-high

Pametni su kupovali, pa malo je reći na vreme, dobri su samo oko 300 puta...

p.s. sada je stvarno kasno, rast sa ovih nivoa je upitan... [ Ivan Dimkovic @ 05.08.2024. 17:40 ] @

Citat: mpman:

Trenutno mi se čini da ono što se naziva danas veštačkom inteligencijom nije ono za šta se predstavlja. U pitanju su samo veliki, specijalizovani modeli mašinskog učenja sa ogromnim bazama podataka. Ako sam dobro razumeo kako sve to funkcioniše, mašinsko učenje se na neki način oslanja na metaheuristiku i evolucione optimizacione algoritme pri čemu se nalazi način da se kvantifikuje određena specijalizovana stvar na osnovu koje se definišu težinski koeficijenti koji se minimizuju kroz niz iteracija dok se ne iscrpi početna baza podataka, pa se ti isti težinski koeficijenti primenjuju nad novim modelima.

Ovo je problem i ovo nije u suštini veštačka inteligencija u smislu u kojem mi mislimo da jeste. Jer ekstrapolacija podataka ne mora nužno da bude uspešna nezavisno od toga na čemu je model treniran, što znači da je jošuvek ljudska intervencija neophodna. Trenutno stanje veštačke inteligencije je da ona ne može da smisli ništa novo, već kombinuje stvari na osnovu već postojećih primera. Ona ne razume šta radi, o čemu piše, šta slika, već na osnovu kaznenih funkcija koje negativno utiču na minimizaciju težinskih koeficijenata i konačne funkcije cilja dolazi do određenih rezultata. To znači da ona suštinski ne može da uvidi nove šablone i kreira nove stvari, već može samo da radi sa onim na čemu je model treniran.

That being said... Veliki broj poslova upravo to i zahteva. Kombinovanje postojećih rešenja da bi se nešto rešilo, napisalo, nacrtalo. Takvi poslovi su sada ugroženi, ali opet oni koji znaju šta rade i koji su dobri u svom poslu ostaće da "hrane" i kontrolišu algoritam. Što se autonomne vožnje tiče, osim dobrog marketinga koji je gospodin Mask odradio, od toga nema ništa. Jer je vožnja jedan od onih slučajeva gde greške u ekstrapolaciji mogu biti pogubne. Ona može biti dovoljno dobra u 80% slučajeva, ali u 20% slučajeva će koštati života. Jer vožnja je jedan od onih stvari u kojoj će se uvek javljati pojave koje niko nije mogao da predvidi u datim okolnostima.

Ono što je strašno i što je opasno jeste to što se ljudi opuštaju. Volan u novim vozilima nema vizičku konekciju sa točkovima. Automobili su visoko uvezani tehnološki sistemi koji mogu da komuniciraju jedni s drugima. Do sada je bilo x skandala gde su već sadašnji automobili špijunirali svoje korisnike, a automobilske kompanije su prodavale podatke o tome gde su njihovi korisnici vozili, kada, kako i koliko osiguravajućim kućama koje su posle na osnovu toga podizale premiju za osiguranje automobila. Osim ogromne invazije privatnosti, zamislite koliko će lako biti rešiti se političkih protivnika zbog "baga u sistemu" ili "loše procene veštačke inteligencije".

Problem sa terminom "vestacka inteligencija" je to sto ne znamo zapravo sta je inteligencija uopste, prirodna ili ne.

Znaci termin koji nema kompletno objasnjenje iz prvih pricipa (a ni iz 'petih' principa) je "nalepljen" na nesto drugo zato sto 'lici' u nekom povrsinskom smislu.

Ali na kraju krajeva, pitanje terminologije je sekundarna stvar - glavno pitanje je sta neka stvar resava (ili ne). [ mpman @ 05.08.2024. 21:25 ] @

Citat: Ivan Dimkovic: Problem sa terminom "vestacka inteligencija" je to sto ne znamo zapravo sta je inteligencija uopste, prirodna ili ne.

Inteligencija jeste definisana, ali nije mehanizam njenog funkcionisanja.

Citat: Ivan Dimkovic:Znaci termin koji nema kompletno objasnjenje iz prvih pricipa (a ni iz 'petih' principa) je "nalepljen" na nesto drugo zato sto 'lici' u nekom povrsinskom smislu.

Ali na kraju krajeva, pitanje terminologije je sekundarna stvar - glavno pitanje je sta neka stvar resava (ili ne).

Nije to ništa sporno, sporno je što Bogovi marketinga u poslednje vreme svuda ubacuju "AI" u nešto što nema mnogo veze samom veštačkom inteligencijom. To je, na neki način, dezinformisanje potrošača. Pominjem Maska jer je Tesla skoro bila u žiži oko povlačenja tvrdnji da će svi automobili biti u potpunosti sposobni za automatsku vožnju bez vozača, što ovakvi modeli u narednih ko zna koliko decenija neće biti u stanju da rade. Prodali su "beta program" bez ikakvih izgleda da će ljudi ikad dobiti finalni proizvod, a već kupljeni automobili kojima je garantovano da će moći to da koriste su stari već 5+ godina i najverovatnije nikad neće doživeti da uživaju u autonomnoj vožnji koja je bila jedna od stavki zbog kojih su kupili taj proizvod. Obmana potrošača. U suštini, meni smeta pogrešan marketing. I što se ljudima tim terminom daje pogrešna ideja šta to oni tačno kupuju.

[ djoka_l @ 06.08.2024. 13:02 ] @

Citat: Inteligencija jeste definisana, ali nije mehanizam njenog funkcionisanja.

To nije tačno. Ne postoji generalno prihvaćena definicija inteligencije.

Još manje postoji generalno prihvaćena definicija veštačke inteligencije.

Čak i ako uzmemo najlabavije OPISE šta inteligencija obuhvata, onda ne postoji nikakva VEŠTAČKA INTELIGENCIJA.

Ako tvrdiš suprotno, da li je spam filter VI? Da li je antivirus VI? Da li je svaki program za igranje šaha VI? Da li je ELIZA VI? [ Ulfsaar @ 06.08.2024. 13:08 ] @

Citat: Inteligencija jeste definisana, ali nije mehanizam njenog funkcionisanja.

Jedan poznati AI naučnik tvrdi da je inteligencija (još uvek) jedno od tri velika naučna pitanja:

https://x.com/ylecun/status/1819670025155850466

Kao i da je svest samo deo tog glavnog pitanja. U tom slučaju bi stvaranje mašina koje mogu da nas zamene u svemu verovatno bilo lakše za dostizanje.

Skoro je izašao jedan eksperimentalni rad koji ukazuje da kvantna teorija svesti Penroza i Hamerofa možda i nije za odbacivanje. Svest je prema toj teoriji ne deo pitanja inteligencije, nego fundamentalna vučna sila koja živim organizmima daje volju za životom (i na nivou molekula). To je sloj ispod mreže neurona koji neuroni koriste kad god postoje, ali on funkcioniše i u organizmima gde ih nema. Meni kao laiku izgleda da je to baš ono što i nedostaje današnjoj veštačkoj inteligenciji da bi bila "čovekolika". Ako bi ova teorija bila tačna, onda bi nam pravljenje te prave veštačke inteligencije potencijalno bilo veoma zakomplikovano. [ Ivan Dimkovic @ 06.08.2024. 14:12 ] @

Teorija svesti Penroza i Hamerofa nije kvantna u nekom kanonicnom smislu, zato sto ukljucuje stvari koje nisu eksperimentalno potvrdjenje i nisu deo potvrdjene kvantno-mehanicke teorije (u stvari jos gore - postoje prilicni problemi koje bi morali da rese / objasne, ali to je vec solidan offtopic).

Ali to zapravo nije ni bitno - sve i da je ta teorija tacna, to ne znaci da je primarni mehanizam te teorije odgovoran za "svest".

Takodje, ne znaci ni da je to jedini moguci mehanizam odgovoran za "svest".

A cak i da sve to zanemarimo, ne sledi nuzno da su inteligentno ponasanje i svest identicna pojava ili nerazdvojne pojave, tj. da je za inteligentno ponasanje nuzno posedovanje svesti.

TL;DR - u kontekstu diskusije, ne menja nista.

[ mpman @ 06.08.2024. 15:11 ] @

Zanimljiva je tema za diskusiju :D

Citat: djoka_l:

Citat: Inteligencija jeste definisana, ali nije mehanizam njenog funkcionisanja.

To nije tačno. Ne postoji generalno prihvaćena definicija inteligencije.

"Human intelligence is, generally speaking, the mental quality that consists of the abilities to learn from experience, adapt to new situations, understand and handle abstract concepts, and use knowledge to control an environment. However, the question of what, exactly, defines human intelligence is contested, particularly among researchers of artificial intelligence, though there is broader agreement that intelligence consists of multiple processes, rather than being a single ability." [1]

Međutim, postoje teorije koje opisuju osobine inteligencije. Neke su sumirane u ovom radu: [2][\url]. U suštini sve ove teorije imaju određena preklapanja i nadogradnje, ali sumira ih Enciklopedija Britanika kao:

"Human intelligence, mental quality that consists of the abilities to learn from experience, adapt to new situations, understand and handle abstract concepts, and use knowledge to manipulate one’s environment." [url=https://www.britannica.com/technology/artificial-intelligence][1]

Veštačka inteligencija je nešto što oponaša prirodnu inteligenciju. LLM-ovi koji se trenutno plasiraju i reklamiraju kao veštačka inteligencija nemaju glavne aspekte ovih definicija. Ne mogu se prilagoditi novim situacijama, novim okruženjima, ne razumeju materiju i ne mogu da razmišljaju niti barataju sa apstraktnim stvarima.

Citat: djoka_l:Još manje postoji generalno prihvaćena definicija veštačke inteligencije.

Čak i ako uzmemo najlabavije OPISE šta inteligencija obuhvata, onda ne postoji nikakva VEŠTAČKA INTELIGENCIJA.

Ako tvrdiš suprotno, da li je spam filter VI? Da li je antivirus VI? Da li je svaki program za igranje šaha VI? Da li je ELIZA VI?

Nije spam filter VI, niti antivirus, niti programi za igranje šaha, a bome nije ni ChatGTP, Bing Copilot, AI Pin, Samsung AI i slični. Ako su bar četiri poslednja sa AI u naslovu "veštačka inteligencija", onda su i rezultati gugl pretrage bili, gugl adsensa, preporuke na youtube-u, spoitfy-u... A oni to nisu. To su algoritmi pravljeni za specifičnu stvar i to i rade, kao što su to i LLM-ovi.

Citat: Ulfsaar:

Citat: Inteligencija jeste definisana, ali nije mehanizam njenog funkcionisanja.

Jedan poznati AI naučnik tvrdi da je inteligencija (još uvek) jedno od tri velika naučna pitanja:

https://x.com/ylecun/status/1819670025155850466

U suštini, nije problem definicija. Jer ako uzmemo da inteligencija ne opisuje jednu pojavu, jednu osobinu, već više osobina i mogućnosti, onda razlaganje svake od ovih mogućnosti pojedinačno i njihovim kombinovanjem može da se dobije nešto što liči na inteligenciju. Problem je što mehanizam iza tih osobina nije razrađen. Takođe jedan od vodećih naučnika u ovom polju je skoro dao jedan primer. Parafraziraću: "Ćerku sam hteo da naučim da vozi tako što bih joj puštao 100 000 h video snimaka o vožnji. Prvo se naljutila na mene, a onda je sa instruktorom za manje od 20h savladala bez problema." Jako je teško definisati šta znači razumevanje, što je na neki način i prepreka za rešavanje problema veštačke inteligencije.

Citat: Ulfsaar:

Kao i da je svest samo deo tog glavnog pitanja. U tom slučaju bi stvaranje mašina koje mogu da nas zamene u svemu verovatno bilo lakše za dostizanje.

Skoro je izašao jedan eksperimentalni rad koji ukazuje da kvantna teorija svesti Penroza i Hamerofa možda i nije za odbacivanje. Svest je prema toj teoriji ne deo pitanja inteligencije, nego fundamentalna vučna sila koja živim organizmima daje volju za životom (i na nivou molekula). To je sloj ispod mreže neurona koji neuroni koriste kad god postoje, ali on funkcioniše i u organizmima gde ih nema. Meni kao laiku izgleda da je to baš ono što i nedostaje današnjoj veštačkoj inteligenciji da bi bila "čovekolika". Ako bi ova teorija bila tačna, onda bi nam pravljenje te prave veštačke inteligencije potencijalno bilo veoma zakomplikovano.

Iskreno, ne bih u ovo mešao svest i ne verujem da to nedostaje današnjoj inteligenciji, već razumevanje. Kada mašina bude mogla da razume koncepte, objekte, boje, zvukove, ideje, onda će razumeti i probleme, a samim tim će biti jednostavnije doći do nekog rešenja. Svakako daleko smo od toga. Svakako, LLM koji se maskira kao inteligencija, po meni bar, a nisam ni jedini u naučnoj zajednici, nije veštačka inteligencija.

Edit: Gledam u poruku i ne vidim gde grešim u linkovanju.

[ Ivan Dimkovic @ 06.08.2024. 16:11 ] @

Uh... I "razumevanje" je jos jedan nezgodan pojam.