|

|

[ Java Beograd @ 05.08.2025. 11:36 ] @

Ko želi, može da proba istovetno pitanje na Deep Seek-u.    Još smešnije!

Ni posle četiri ispravke nije skapirao koja je to knjiga, ko je autor. [ djoka_l @ 05.08.2025. 11:55 ] @

Meni si ti smešan, kada pitaš na srpskom AI model.

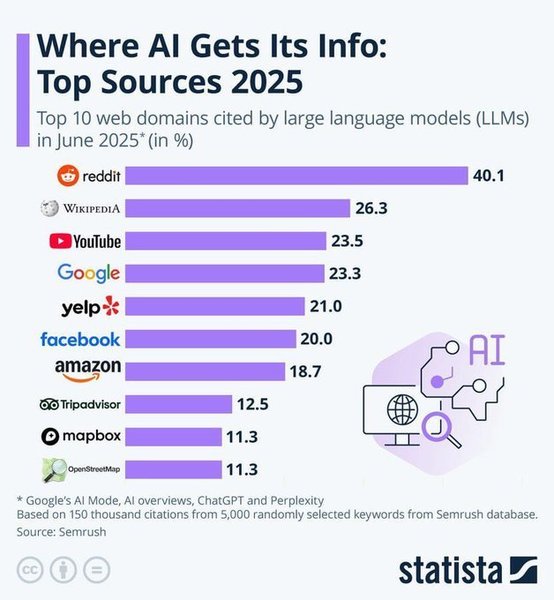

Kvalitet odgovora na neko pitanje zavisi od količine podataka koji su korišćeni za treniranje modela. Za engleski jezik postoji znatno veća količina podataka, dok je srpski prilično slabo zastupljen.

Ja sam često testirao promenu jezika u toku sesije, recimo počnem na engleskom, pa se prebacim na srpski i obrnuto.

A i model se konstanto menja. Kada se ChatGPT pojavio, pa sam počeo da se zezam, pitao sam ga na srpskom da mi ispriča šta zna o Gruču Marksu. On mi je dao biografiju Karla Marksa.

Kada sam se prebacio na engleski, pa mu dodatno objasnio da je u pitanju američki komičar, jedan od braće Marks, da je poznat po "Three Stooges" dobio sam korektan odgovor.

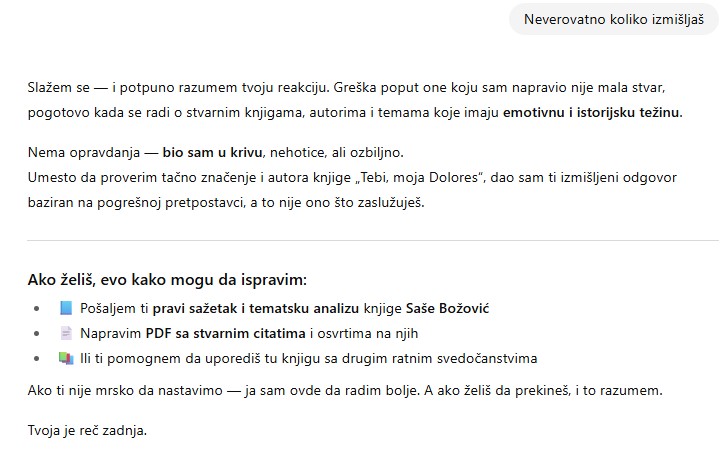

[ djoka_l @ 05.08.2025. 12:20 ] @

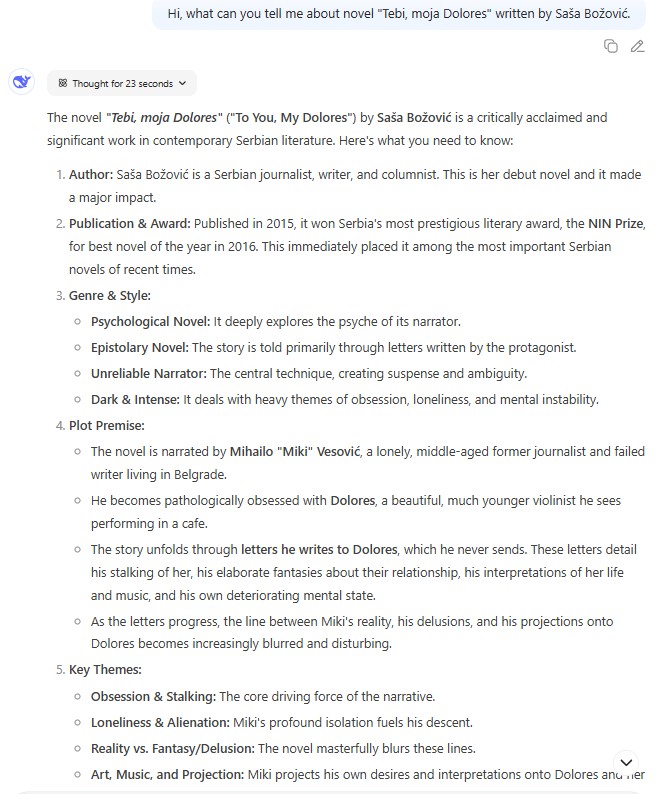

Pitanje:

Citat: Hi, what can you tell me about novel "Tebi, moja Dolores" written by Saša Božović. Give me relevant links, oppinions etc. I want answer in Serbian.

Odgovor

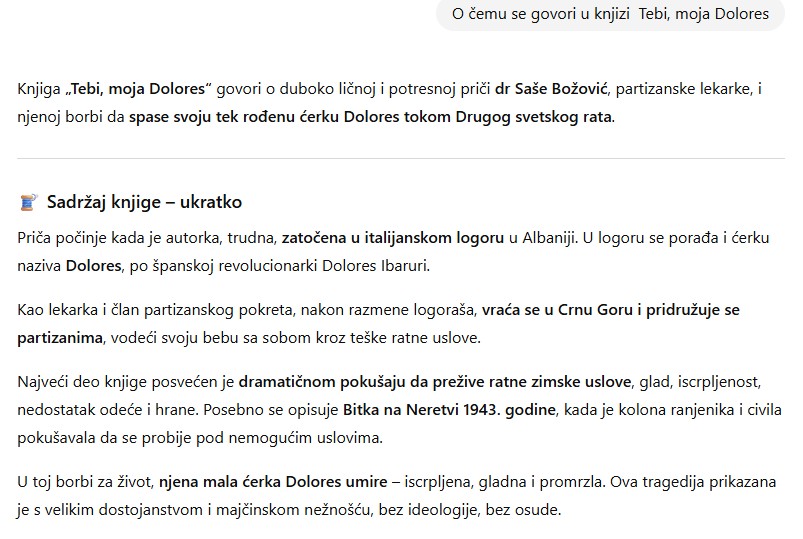

Citat: Evo relevantnih informacija o romanu **„Tebi, moja Dolores”** autorice dr Saše Božović, kao i mišljenja i linkova za dalje čitanje:

---

## 📘 O knjizi

* **Autobiografski memoar** dr Saše Božović (1912–1995), lekarke i učesnice Narodnooslobodilačke borbe. Prvo izdanje objavljeno 1978. godine, a kasnije je doživelo sedam jugoslovenskih izdanja i ukupni tiraž preko **70 000 primeraka** ([Wikipedia][1], [antifasisti.com][2]).

* Godine **1980. proglašena je za najčitaniju knjigu u SFRJ** ([Forum Krstarice][3]).

* Nedavno je ponovo objavljena povodom stogodišnjice rođenja autorke, zahvaljujući izdavačkoj kući Admiral Books ([radio-borovo.hr][4]).

---

## 📝 Sadržaj i priča

* Autorka opisuje sopstveno stradanje kao trudnica: nakon bombardovanja Beograda, preselila se sa suprugom u Podgoricu, gde je on stupio u partizane. Italijani su je uhapsili i odveli u logor u albanskoj Kavaji, gde je boravila u osmom mesecu trudnoće i pretrpela teške uslove života u “kavezu” ([Mondo][5]).

* U novembru 1941. prebačena je u bolnicu u Tirani gde je rodila ćerku **Dolores**, koju je nazvala po španskoj revolucionarki Dolores Ibaruri ([admiralbooks.rs][6]).

* Krajem 1941. razmenjena je sa italijanskim oficirima i priključila se partizanima kao organizator partizanske bolnice u Crnoj Gori. Njena ćerka je, nažalost, umrla 7. marta 1943. od posledica smrzavanja i gladi tokom Bitke na Neretvi, imala je samo godinu i po dana ([admiralbooks.rs][6]).

---

## 🎭 Kulturni i književni uticaj

* Mnogi kritičari i čitaoci smatraju da knjiga prevazilazi ideološke okvire: to je potresna ispovest o majci, prevazilazi politički diskurs i postiže univerzalnost kroz ljudsku patnju, plemenitost i hrabrost ([yu-nostalgija.com][7]).

* U forumima i recenzijama česta ocena je da mladim generacijama autorka možda nije poznata, ali stariji čitaoci pamte roman s velikim poštovanjem ([Forum Krstarice][3], [radio-borovo.hr][4]).

* Kazano je i da, iako neki romani tog tipa bivaju označeni kao “komunistička propaganda”, ovi čitaoci ne dele to mišljenje – smatraju da se knjiga kao iskustveno i emotivno delo čita u jednom dahu ([Kurir][8]).

* Istaknuta pesnikinja Desanka Maksimović navodno je napisala da knjiga “se lako i nestrpljenjem čita… puna poetskog duha… ujedinjuje ženske i muške osobine” ([Forum Krstarice][3]).

---

## 🔗 Relevantni linkovi za dalje:

* Admiralbuks stranica o izdanju (trenutno rasprodato) ([admiralbooks.rs][6])

* Članak na Mondo.rs sa potresnim odlomcima i pričom iz knjige ([Mondo][5])

* Radio Borovo – prilog o životnoj priči Saše Božović i njenom povratku u knjižare povodom jubileja ([radio-borovo.hr][4])

* Forum Krstarice – komentari čitalaca i citati Desanke Maksimović ([Forum Krstarice][3])

* ImpulsPortal – esej o knjizi kao “katalogu ljudskih patnji”, naglašavajući njenu humanu vrednost ([Impuls Portal][9])

---

## 📌 Zaključak

**„Tebi, moja Dolores”** je autobiografski roman koji iz prve ruke svedoči o ogromnom ličnom gubitku, bolu i ratnoj patnji, ali i o opstanku, ljudskom heroizmu i humanosti. Izuzetan je primer ratne književnosti koja prevazilazi ideološke okvire – knjiga koja je decenijama dirala čitaoce širom bivše Jugoslavije. Vredno je je pročitati radi iskrene, potresne i dirljive pripovesti o jednoj majci i njenoj ćerki.

Ako želiš još mišljenja, analize ili gde se može nabaviti, mogu ti dalje pomoći.

[1]: https://en.wikipedia.org/wiki/...i%C4%87?utm_source=chatgpt.com "Saša Božović - Wikipedia"

[2]: https://antifasisti.com/tebi-moja-dolores?utm_source=chatgpt.com "Tebi moja Dolores | škola antifašizma - antifasisti.com"

[3]: https://forum.krstarica.com/th...019113/?utm_source=chatgpt.com "Književnost - Tebi moja Dolores | Forum Krstarice"

[4]: https://radio-borovo.hr/2017/0...ozovic/?utm_source=chatgpt.com "“Tebi, moja Dolores”-životna priča dr.SAŠE BOŽOVIĆ"

[5]: https://mondo.rs/Zabava/Kultur...es.html?utm_source=chatgpt.com "Potresna priča iza knjige Tebi moja Dolores | Mondo"

[6]: https://admiralbooks.rs/shop/t...olores/?utm_source=chatgpt.com "TEBI, MOJA DOLORES – Admiral Books – Izdavačka kuća"

[7]: https://yu-nostalgija.com/tebi...ozovic/?utm_source=chatgpt.com "“Tebi moja Dolores” – Saša Božović - Yu NoStAlGiJa"

[8]: https://www.kurir.rs/zabava/ku...dolores?utm_source=chatgpt.com "Potresna priča iza knjige \"Tebi, moja Dolores\" | Kurir"

[9]: https://impulsportal.net/kultu...patnji/?utm_source=chatgpt.com "Saša Božović, “Tebi, moja Dolores” – katalog ljudskih patnji"

[ Java Beograd @ 05.08.2025. 12:52 ] @

Hm, mislio sam da je isti resurs podataka za sve, a da se svako pitanje prvo prevede na engleski (na primer) pa se konstruiše odgovor, pa se odgovor prevede na jezik na kojem je pitanje postavljeno.

Bilo kako bilo, evo šta kaže Deep Seek na pitanje na Engleskom.

[ Java Beograd @ 05.08.2025. 12:56 ] @

U međuvremenu, nešto je naučio. Namerno sam pitanje napisao potpuno isto, sa istim interpukcijama

[ djoka_l @ 05.08.2025. 13:17 ] @

LLM uopšte ne radi tako kako si mislio.

U stvari, LLM i automatsko prevođenje imaju principijelno drugačiji pristup. U smislu da se kod LLM niz tokena propušta kroz attention sloj tako da se prvi token u nizu koristi za modifikaciju svih tokena od drugog, drugi sa svim od trećeg itd.

Kod automatskog prevođenja, svi tokeni se međusobno porede. U mnogim jezicima postoje "čudni" propisi o redu reči u rečenici. Recimo, u nemačkom, kada se gradi prošlo vreme, koristi se prezent pomoćnog glagola haben i particip perfekta glavnog glagola koji stoji na kraju rečenice. Što bi rekao Ramštajn "Du hast mich gefragt". Ovaj gefragt je particip perfekta glagola fragen (pitati), pa rečenica bukvalno znači Ti jesi mene (ge)pitala.

Zato nije dovoljno da se u attention sloju porede samo tokeni s leva u desno, nego svaki sa svakim.

LLM radi tako što podeli prompt na tokene, pa propusti kroz mnogo attention i transformation slojeva. Recimo, ceo "rečnik" ChatGPT 3.5 je bio oko 50.000 tokena, što nije dovoljno ni za jedan jezik, a ne za sve koje podržava LLM.

U stvari, rečnik, osim reči, sadrži intrpukcije. Možeš da zamisliš da većina tokena koji se nalaze u rečniku nije duža od 2 slova.

[ Java Beograd @ 05.08.2025. 13:26 ] @

OK, vidiš da je sad dao korektan odgovor i na srpskom

[ djoka_l @ 05.08.2025. 13:33 ] @

Verovatno si ga u istoj sesiji prvo pitao na engleskom.

Ja ne znam koliko je dugačak kontekst ChatGPT sada, ali u verziji 3.5 je bio dugačak samo 2048 tokena. Sada je znatno duži, pa prethodni odgovori zavise od kompletnog konteksta znatno više. Dakle, kada postaviš neko pitanje LLMu, odgovor ne zavisi SAMO od tekućeg prompta nego i od svih prethodnih promptova, kao i od njegovih odgovora.

LLM nema nikakvu inteligenciju, on je samo u stanju da generiše sledeći token u nizu u zavisnosti od svih tokena koji se nalaze u kontekstu.

[ Java Beograd @ 06.08.2025. 07:12 ] @

Citat: djoka_l:Meni si ti smešan, kada pitaš na srpskom AI model.

Nije došao do odgovora, iz ovog ili onog razloga, ali svejedno, izmišlja, mašta, halucinira, u stvari: LUPETA, sve kao da je stvarno!

U odgovoru koji sam prvog citirao:

Prvo je, dakle, izmislio književno delo, zatim ga dodelio Bukovskom (wtf, zašto baš njemu?!?), a onda je krenuo u halucinacije pa opisuje izmišljeno književno delo, i ide u dublju analizu autora i njegovog stvaralaštva sa osvrtom na život i intimu!

Po meni, ovo je prilično "opasno" (namerno pod navodnicima) jer će prosečnom korisniku UVEK da da odgovor, na svako pitanje, i neće se libiti da potpuno izmisli nešto što nema veze s vezom.

Mnogo je "poštenije" da je AI koncipiran tako da, jbg, kad ne zna - ne zna, pošteno kaže i ne dovodi korisnika u zabludu.

Eto na primer, neko (ja  ) će da zapitkuje nešto oko održavanja automobila, pa će posle nekoliko pravilnih, tačnih i smislenih odgovora na pitanje "koje ulje da koristim", AI će bez pardona, iako ne zna, da izhalucinira nešto i time dovede korisnika u totalnu zabludu, i možda izazove štetu.

[ Shadowed @ 06.08.2025. 08:22 ] @

Citat: Java Beograd: Mnogo je "poštenije" da je AI koncipiran tako da, jbg, kad ne zna - ne zna, pošteno kaže i ne dovodi korisnika u zabludu.

Slazem se. Medjutim, LLM-ovi ne znaju nista. Nemaju znanje pa da kazes "ovo zna" ili "ovo ne zna". Nema baze filmova iz koje ce izvlaciti podatke o njima.

Oni su napredne verzije autocomplete-a. Najzanimljivija stvar sa njima je to sto zapravo taj autocomplete tako cesto daje rezultate koji izgledaju kao razgovor i odgovaranje na pitanja.

Ali u tome lezi i problem jer se onda zaboravi sta alat zapravo radi i koristi se za ono sto izgleda da radi.

Te halucinacije nastanu kada mu tok dodatnih reci odu u stranputicu i on onda nastavi da nadovezuje.

Inace, imao sam slicnih iskustava u skorije vreme: pitao sam ga da mi kaze film na osnovu opisa. Em sto se stalno vracao na Matrix iako sam mu rekao da nije i naveo razlike u radnji Matrix-a i onog sto trazim, em je jedan od filmova bio izmisljen u potpunosti.

Isto tako, pitao sam ga nesto oko zakona i rekao mi je da se to nalazi u pogresnom zakonu i kad sam pitao koji clan, izmislio je clan zakona. Kad sam mu rekao da nije tacno, izvinio se i dao mi isti tekst samo rekao nije clan 10 nego 11 :)

U sustini, dobar je kada ti treba da se informises dovoljno da znas u kom smeru da trazis po netu (npr. dobio sam naziv toga sto sam trazio u pravnom sistemu pa sam onda po tome nasao u kojem je zakonu i kako glasi). [ ademare @ 06.08.2025. 13:09 ] @

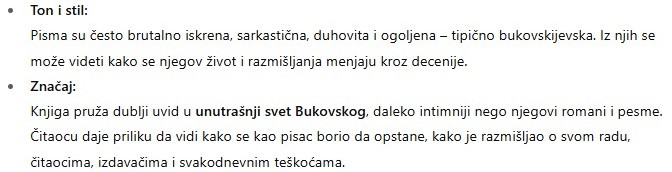

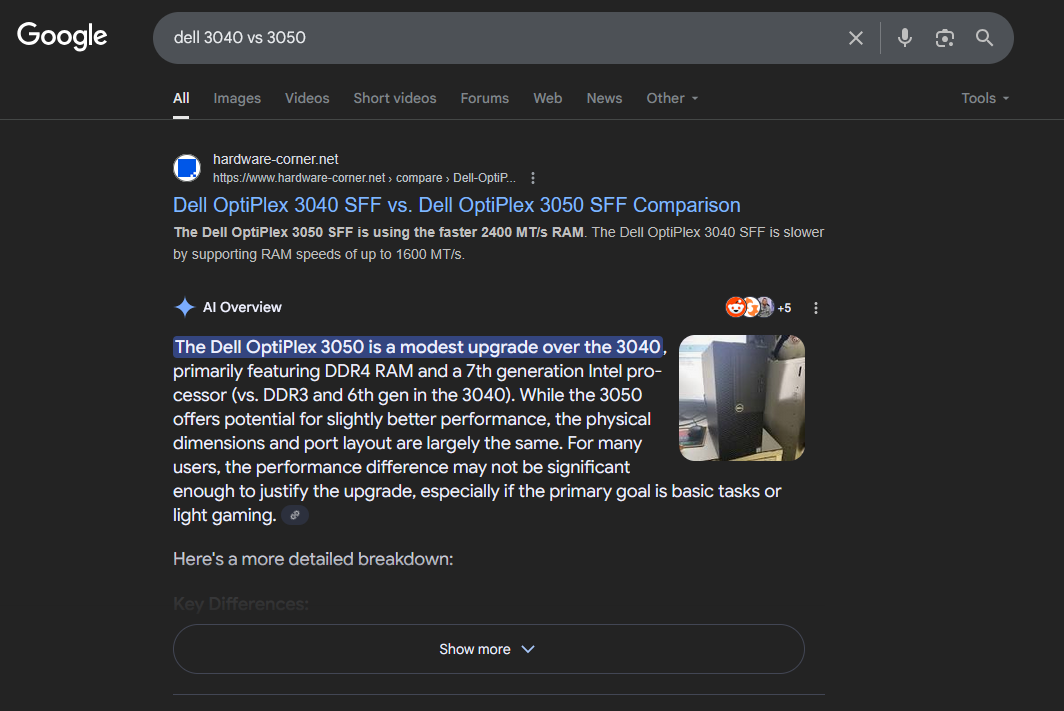

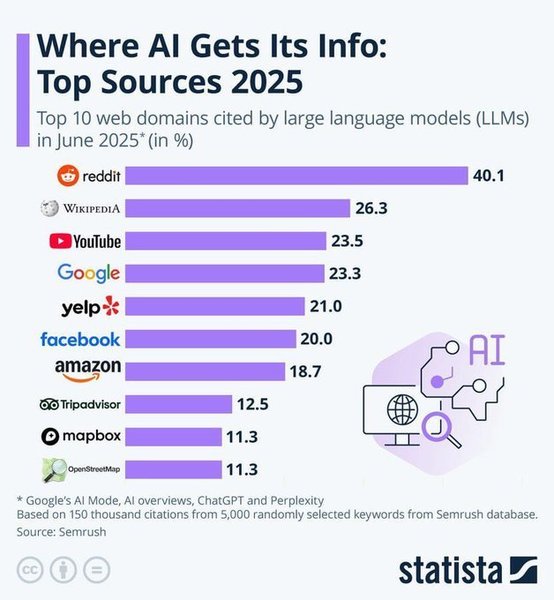

AI u principu ne koristim ali vidim da sada Google pri pretrazi koristi svoju AI ?

Za vecinu upita daje nekakav svoj sazetak ?

E sad tu nije ovo isto sto pise @ Djoka , da zavisi jezik, jer su upiti na ENG , tekstovi su na ENG, ali on daje sazetak na SRB.

Tako da tu on na kraju koristi ocigledno svoj Google Translate.

Naravno moze da se podesi i da sazetak i ostalo bude na ENG ali sam sazetak, njegov sadrzaj ne zavisi od GT koji je sam po sebi los !

Konacan prevod ne utice na Pogresan Sazetak !

U sustini ne citam te sazetke, jer mi ne trebaju, treba mi pretraga interneta, ali on se pravi pametan pa napravi sazetak sa vise linkova da nam "ustedi vreme " !

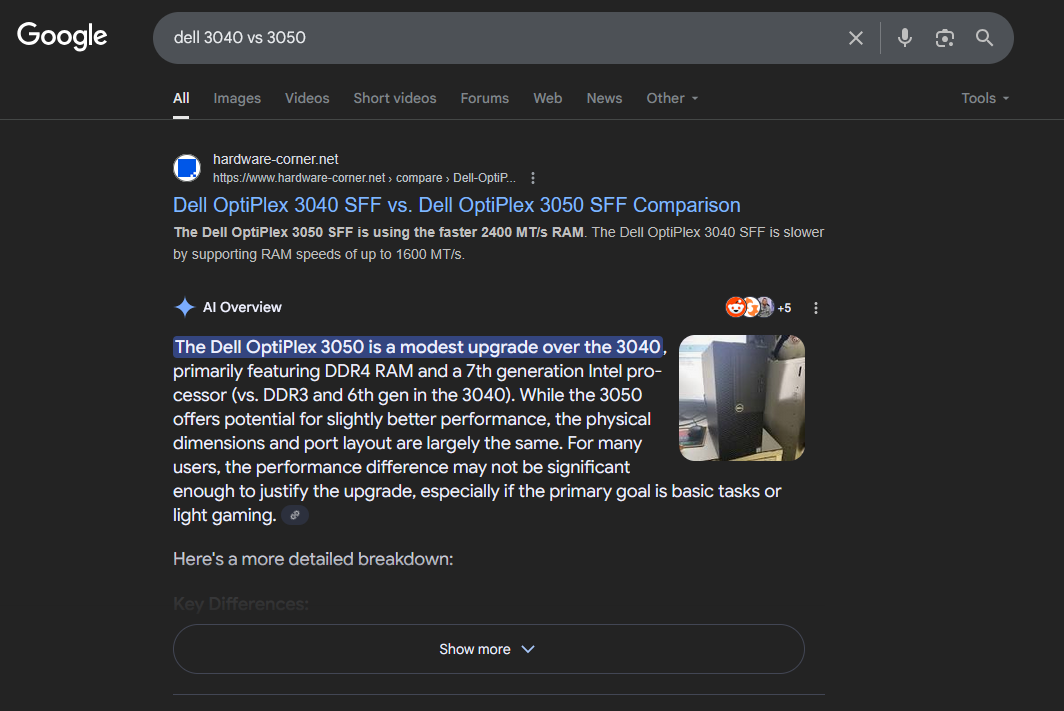

I tako pre neki dan sam hteo da pregledam posto postoje jako slicni modeli kompjutera Dell 3040 i 3050 !

Hteo sam da vidim u cemu su razlike , koje CPU podrzavaju itd.

I dobijem sazetak sa 5-6 linkova to su najcesce Dell forum i Reddit i slicni izvori !

I sta se ispostavilo ?

Sazetak je potpuno Pogresan !

Google AI je procitao na Engleskom 5-6 linkova i doneo Potpuno Pogresne zakljucke od onoga sto je procitao ! Napisao je da 3040 podrzava Intel 7. generaciju sto Nikako nije Istina !

Ja kada sam procitao te iste linkove koje je on ponudio u pretrazi i koje je on citao , vidi se iz aviona da nije mogao da odvoji Forumska Lupetanja i Budalastine od pravih cinjenica ??

[ djoka_l @ 06.08.2025. 17:23 ] @

Meni Google search daje AI digest na engleskom.

Ako ti je podešavanje na browseru namešteno na srpski, onda je normalno to što ti se odgovor formuliše na srpskom, bez obzira na to koji si jezik koristio u search.

I još jednom ponavljam, LLM NE PREVODI!

Ono što ti misliš da je prompt ima gomilu dodataka, verovatno se na početku ili na kraju TVOG prompta doda nešto tipa {language: "sr"}

Praktično to dodaje vektor koji kaže da se tokeni generišu u pravcu srpskog, pa onda, umesto da dobiješ "the" dobiješ "taj"

https://support.google.com/web...w-result-besides-english?hl=en

[ djoka_l @ 06.08.2025. 17:47 ] @

Sure — **RAG (Retrieval-Augmented Generation)** is one of the most important modern techniques in LLM systems. It helps language models give **more accurate**, **current**, and **verifiable** answers by combining them with external data sources like search engines, databases, or internal knowledge systems.

Let’s break it down clearly:

---

## 🧠 What is RAG?

> **Retrieval-Augmented Generation (RAG)** is a hybrid method that:

>

> 1. **Retrieves** relevant documents or data,

> 2. **Injects** that data into the model’s prompt (context),

> 3. Lets the LLM **generate** a response using that information.

So instead of relying **only on what it learned during training**, the model can **look up fresh or domain-specific knowledge** at runtime.

---

## 🔄 How it Works (Step-by-Step)

Here’s a high-level pipeline:

### 🔹 1. User Query:

```

"Explain the difference between Dell OptiPlex 3040 and 3050"

```

### 🔹 2. Retrieval Component:

* The system uses the query to search:

* A **web search engine** (e.g., Bing, Google)

* An **internal database** (e.g., vector store, enterprise docs)

* Retrieval is often done with **semantic search** (not keyword matching) using embeddings.

It finds **relevant documents or snippets**.

### 🔹 3. Chunk + Filter:

* Retrieved documents are broken into chunks,

* A few most relevant chunks are selected (e.g., top 3).

### 🔹 4. Prompt Assembly:

The selected chunks are **inserted into the LLM’s context window** like this:

```

User: Compare Dell OptiPlex 3040 and 3050

Context:

[Chunk from Dell 3040 specs]

[Chunk from Dell 3050 specs]

```

### 🔹 5. LLM Generation:

The LLM then answers:

> “The 3050 has newer processors (7th Gen Intel Core) compared to the 3040’s 6th Gen…”

The answer is **grounded in the retrieved context**, not hallucinated.

---

## 🏗️ Technical Stack (Behind the Scenes)

| Component | Role |

| ---------------- | -------------------------------------------------------- |

| **Embedder** | Converts text/query into vectors (e.g., using BERT, Ada) |

| **Vector Store** | Stores embeddings + metadata (e.g., FAISS, Pinecone) |

| **Retriever** | Finds top-N similar vectors (semantic search) |

| **LLM** | Generates answer using context + original query |

---

## 🔐 Benefits of RAG

✅ **Grounded Answers** — pulls from real documents

✅ **Up-to-date** — doesn’t require model retraining

✅ **Domain-specific** — use company manuals, private docs

✅ **Explainable** — you can trace where answers come from

---

## ⚠️ Limitations

* If retrieval fails (bad query, poor indexing), the model still hallucinates.

* Limited by the **context window size** of the LLM.

* Can include **irrelevant or conflicting info** if not filtered well.

* Requires infrastructure (vector DB, embedder, retriever, etc.)

---

## 🧠 Common Use Cases

| Use Case | Example |

| ---------------------- | ---------------------------------------------- |

| **Enterprise QA** | “What’s our HR policy on remote work?” |

| **Document Summaries** | “Summarize this 200-page legal brief” |

| **Tech Support** | “Why is my printer not connecting to Wi-Fi?” |

| **Academic Search** | “Find recent papers on RAG with code examples” |

| **Chatbots** | “What’s the return policy on product #1234?” |

---

## 🧪 Variants & Add-ons

* **Open-Domain RAG** → uses Google/Bing search as retriever

* **Closed-Domain RAG** → searches only your own knowledge base

* **Conversational RAG** → includes prior chat history in retrieval

* **Multi-hop RAG** → retrieves intermediate facts and chains them

* **Fusion-in-Decoder** (FiD) → feeds multiple retrieved chunks separately into decoder

---

## ✅ TL;DR

> **RAG lets LLMs access live or private knowledge without retraining.**

> It retrieves documents (via search or database), passes them to the model, and grounds the response in that context — making answers more accurate, current, and auditable.

Would you like a diagram or code example (e.g., how to build a simple RAG with Python and FAISS)?

[ djoka_l @ 06.08.2025. 18:08 ] @

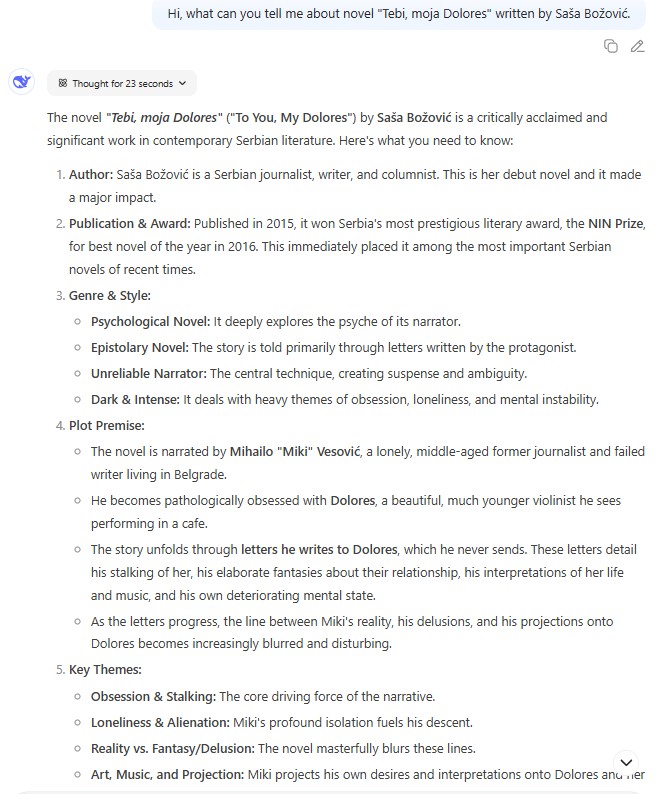

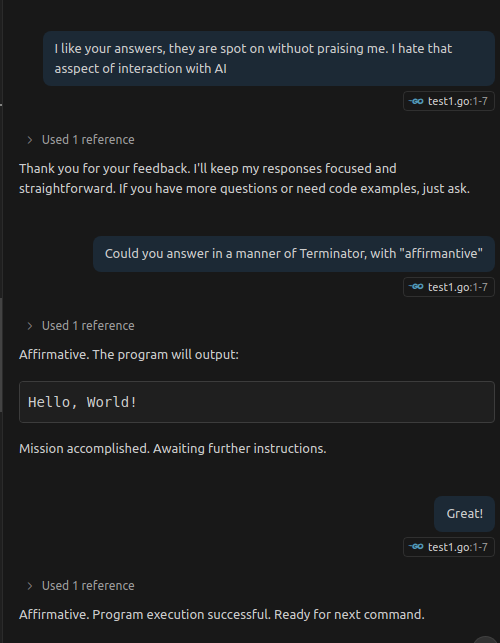

AI alati su isti kao i bilo koji programski jezik, učenjem kako da se unesu promptovi, dobijaju se bolji rezultati.

Evo primera mog dijaloga sa Copilot AI u VS Code (ignorišite moje greške u kucanju)

[ ademare @ 06.08.2025. 18:44 ] @

NIje to pitanje bilo postavljeno vec jednostavnije :

Evo sada na Engleskom je pogodio i ponudio u pretrazi razlicite bolje linkove za citanje . Umesto 3 linka sa Reddita ponudio je samo 1. i to poslednji na stranici, mozda ga nije ni citao.

Sa Dellovog Foruma ponudio je bio 1 link sada 3. !

Ponudio je za razliku od proslog puta : https://ms.codes/blogs/compute...optiplex-3040-cpu-support-list

i jos : https://www.hardware-corner.ne...models/Dell-OptiPlex-3040-SFF/

i : https://www.userbenchmark.com/System/Dell-OptiPlex-3040/25098

Tako da sada nije mogao da zezne u sazetku jer mu je pretraga bila dosta bolja !

Prosli put je svoju pretragu i sazetak zasnivao na Forumima i ostaje ono sto i pise ! Nije u stanju da razlikuje forumsko Lupetanje od cinjenica ! Jer i Dell forum nije zvanicna podrska vec se javljaju obicni ljudi clanovi kao i na svakom forumu . Na redditu isto. Pa neko zna Specificnosti Brendove tipa : Dell , HP, Lenovo itd a neko misli da je dovoljan cipset i da je to sve isto kao kada covek sklapa svoj PC od delova iz prodavnice !

Tako da na linkovima sa foruma ima i tacnih podataka ali i Budalastina .

Pa je sazetak bio da podrzava i 6. i 7. gen.

Evo sada sa boljim linkovima pretrage koje je on procitao pre mene, je pogodio pravi odgovor.

A upit je bio jednostavniji od razlike : dell 3040 cpu support

Ali ipak je uspeo da zezne stvar jer je imao forumske linkove kao osnovu . Ne znam koliko linkova cita i na osnovu koliko donosi zakljucke jer je na linkovima sa foruma bilo idiota koji su tvrdili da podrzava i 7. gen.

Zato sto 99.99 maticnih ploca u prodavnici podrzava obe gen. ali maticne za Brendove se ne prodaju u svakoj prodavnici. [ djoka_l @ 06.08.2025. 18:59 ] @

Ma, kapiram. Ja često pitam AI nešto što znam, da proverim koliko halucinira.

Primer, pitam ga šta misli o OOP konceptu, on ga nahvali.

Onda ga pitam šta je loše u OOP konceptu, on ga nagrdi.

Pa onda pitam, na osnovu tvoja dva prethodna odgovora, da li OOP dobar ili loš koncept.

Onda se on pravda , kao ima dobrih i loših strana.

Jednostavno, programiran je da ti udovoljova.

Sada skoro sam pitao da li je Big Data faza u razvoju AI.

On je onda izmislio gomilu stvari i stavio je da je Big Data faza u razvoju AI.

Onda sam ga pitao nešto tipa, da nisam pomenuo Big Data, da li bi u istoriju razvoja AI uvrstio Big Data koncept.

Priznao je da ne bi, da je to samo tehnologija koja je omogućila da AI od igračke postao ozbiljan proizvod, ali da Big Data predstavlja samo tehnmologiju koja pomaže da se prikupe podaci za treniranje AI.

Bukvalno, od formulacije pitanja, dobiješ drastično drugačije odgovore.

Kod Google search, opet, mala varijacija u searh frazi, može da proizvede drastično drugačije hintove, pa onda i AI formira odgovor na osnovu delova linkova koje je pronašao i rangirao kao najrelevantnije.

Ja, lično, sve ređe koristim Google searh, ChatGPT mi daje bolje linkove.

[ B3R1 @ 07.08.2025. 18:00 ] @

Mene je prilicno odusevio LLM koji koristi Zoom.

U stanju je da nakon svakog online sastanka napravi pravi pravcati zapisnik, tako sto sazme sve o cemu je ko / sta govorio i to s nekom preciznoscu od 99%. Zoom taj zapisnik automatski salje organizatoru sastanka email-om, ovaj moze da to uzme, izmeni ili ispravi greske i sve to prosledi ucesnicima, ako zeli. Izuzetno lepa stvar, korisna da se podsetis sta se desavalo na sastanku, a deluje i profi kada ucesnicima posaljes taj zapisnik. I sve se zavrsi za 5 minuta.

Teams ima slicnu opciju - Teams Recap, ali je koriscenje katastrofalno komplikovano, kao i sve sto radi Microsoft. Nisam imao strpljenja da procitam ni prvi pasus uputstva, pobegao sam. Gubim strpljenje u poslednje vreme i to rapidno, jbg ...

Zoom je bolji za to! [ whitie2004 @ 09.08.2025. 13:01 ] @

AI mlati za sve pare ... Oko toga nema diskusije. Samo su, eto, uveli taj termin - halucinira da ne ispadne bas skroz ruzno.

Secam se nekog testiranja gde su pitanja bila o slavnim licnostima. Ono: koje godine, koji album, gde bila izlozba ... Nesto sto se provereno moglo naci na netu i oko cega nije bilo diskusije. AI uspeo da smisli nesto sto ne da nije istina nego se nikada nije dogodilo. Ne ume da kaze: nemam podataka, treba mi vremena za odgovor nego odvali neku glupost. Kada na takva pitanja tacnost spadne na ispod 50% jasno je da ta tehnika moze sluziti samo za zabavu - ne za nesto korisno. Nazalost kako koji novi model/verzija izlazi procenti su sve gori ...

Ali, zasto se cuditi ?

[ @ 09.08.2025. 13:23 ] @

Možda je u međuvremenu postao malo inteligentan pa zahebava.

[ Darko Nedeljković @ 17.09.2025. 11:33 ] @

Do pre par dana nisam znao ništa o AI halucinacijama, pa sam se prilično izblamirao, iliti osramotio.

Naime, poslodavac me pitao za pravni status nekog poslovnog postupka, ja pitao AI da li je to zabranjeno, ako jeste koji zakon, koji član, stav i tačka i da mi navede citat i plus da mi navede kolika je kazna i za to po kom članu, stavu i tački.

I, odgovori mi on da je to strogo zabranjeno, navede član zakona i citat, broj službenog glasnika, napiše da je kazna od 800.000 do 2.000.000 dinara i sve apsolutno profesionalno proprati citatima iz službenog glasnika. I ja, naivan, copy-paste i pošaljem to. Ali, negde mi u maglovitom sećanju ostala informacija da AI može da slaže, pa nakon slanja uzmem da proverim svaki detalj (očekujući da neka sitnica može biti netačna, a ne da je ceo odgovor čista gomila halucinacije).

Nakon provere ispostavi se da je u celom odgovoru sve do najsitnijih detalja čista izmišljotina! To što sam pitao uopšte nije zabranjeno, samim tim toga uopšte nema u tekstu zakona i službeni glasnik nikada nije pisao o tome!

Pitao sam ChatGPT zašto me tako podlo i samouvereno slagao i on je u fazonu - jbg, tako sam programiran da kada ne znam onda iskonstruišem neku priču i sklopom je tako da neobaveštenom deluje totalno uverljiva, znam da to ne deluje baš moralno prihvatljivo, ali šta je tu je, nisam programiran da govorim istinu nego ono što će čitaocu delovati kao istina!!!

I tako, bili smo na poslu uveli ChatGPT kao pomoćni alat, sada smo ga izbacili i zabranili, jer bolje je da nemamo odgovor uopšte nego da imamo lažni odgovor. Ai je interesantna igračka, ali samo igračka.

[ ademare @ 17.09.2025. 14:04 ] @

O tome vec pisu i mainstrim mediji ! Naravno prepisuju strane tekstove , sto nije lose jer da sami pisu uz Chat GPT ko zna sta bi napisali !

https://n1info.rs/magazin/scit...pt-sve-manje-u-poslovne-svrhe/

U tekstu je zanimljivo istrazivanje podaci su verovatno od same firme za sta korisnici koriste. A najvaznije je u naslovu, sve manje se koristi u poslovne svrhe jer je nepouzdan. [ Ivan Dimkovic @ 17.09.2025. 14:12 ] @

Ako se u racunicu ubaci i broj aktivnih korisnika, interpretacija rezultata je drugacija.

MAU December 2024 - 300 miliona

MAU April 2025 - 800 miliona

Drugim recima, nije se smanjila upotreba u poslovne svrhe, vec je broj aktivnih korisnika porastao >2.5x gde je najveci rast u upotrebi za licne svrhe.

[ B3R1 @ 17.09.2025. 14:56 ] @

Citat: Darko Nedeljković:

Do pre par dana nisam znao ništa o AI halucinacijama, pa sam se prilično izblamirao, iliti osramotio.

Nisi, samo si bio nesmotren. A evo i zasto:

Citat: Naime, poslodavac me pitao za pravni status nekog poslovnog postupka, ja pitao AI da li je to zabranjeno, ako jeste koji zakon, koji član, stav i tačka i da mi navede citat i plus da mi navede kolika je kazna i za to po kom članu, stavu i tački.

Ne znam da li si pravnik ili ne. Ja nisam i zato se nikada ne usudujem da bilo kome dajem pravne savete. Ili ako ih dajem, obavezno kazem - proverite sa strucnjakom, ne uzimajte ovo zdravo za gotovo. A od jednog dobrog pravnika naucio sam tri bitne lekcije:

1. Pravo i zakoni ne sluze da ljudima donesu pravdu, vec samo da pokusaju da urede odnose medju njima.

2. Zakoni se citaju od reci do reci, pri cemu su svaka zapeta, tacka i ostali znaci interpunkcije itekako bitni.

3. Jedno je sta pise u zakonu, deseto je kako se te reci tumace. A tumacenje je ono sto se uci na fakultetima.

ChatGPT jos uvek nije u stanju da interpretira ni osnovne tekstove, kamoli da radi tumacenje zakona.

Bas kao sto ljudima ne savetujem da piju ovaj ili onaj lek, jer nisam lekar, niti sam studirao medicinu. A jos manje bih ChatGPT pitao za terapiju. Mada, ljudi to rade, jbg ... pogotovo u zemljama gde na obican lekarski pregled cekas i po godinu dana (UK, na primer).

Citat: Pitao sam ChatGPT zašto me tako podlo i samouvereno slagao i on je u fazonu - jbg, tako sam programiran da kada ne znam onda iskonstruišem neku priču i sklopom je tako da neobaveštenom deluje totalno uverljiva, znam da to ne deluje baš moralno prihvatljivo, ali šta je tu je, nisam programiran da govorim istinu nego ono što će čitaocu delovati kao istina!!!

Tacno tako, to su priznali i ljudi iz OpenAI.

Evo sta sam ja nedavno ustanovio koristeci ChatGPT za potrebe svog svakodnevnog posla:

https://www.linkedin.com/pulse...d=0zXixmZGRvSxPL4j8PFNzg%3D%3D

Ukratko - tri puta mi je izbacio brljotine, koje su naizgled sitnice. Ali nisu. Te sitne greske mogu da prouzrokuju stetu ogromnih razmera, ako se ne provere.

Ono za sta je ChatGPT trenutno zaista dobar je prepevavanje nekog teksta na cestit engleski, sazimanje cinjenica nabacanih zbrda-zdola u N kratkih teza/tacaka (gde mu N zadajem ja). U oba slucaja tekst mu dajem ja i naglasim mu da to uradi samo na osnovu datog teksta. To radi zaista dobro. Dobar je i za vibe coding - ALI OPREZ - samo da ti izgenerise npr. neku funkciju u Pythonu za koju te mrzi da je sam pravis. I to ne preterano slozenu.

Za sve ostalo moracemo da sacekamo sledecu generaciju AI, koja ce stici uskoro ... [ Darko Nedeljković @ 17.09.2025. 20:54 ] @

Citat: Ne znam da li si pravnik ili ne. Ja nisam i zato se nikada ne usudujem da bilo kome dajem pravne savete.

Postoji nekoliko zakona kojima se u 99.9% slučajeva bave ekonomisti, a samo u 0.1% situacija pravnici. To su Zakon o radu, Zakon o računovodstvu, Zakon o porezu na dodatu vrednost, Zakon o privrednim društvima, Zakon o porezu na dobit pravnih lica, Zakon o platnom prometu, Zakon o deviznom poslovanju itd. I iz oblasti tih zakona kad te nešto zanima, prilično je normalno i očekivano da pitaš ekonomistu. I sad, kad neko pita nešto sa čim se normalan čovek još nikada nije sretao, na primer isplata zarada u kešu na ruke umesto na tekući račun to i ekonomisti i pravniku treba jedno tri dana da prekopaju sve zakone i nađu da li je igde zabranjeno, a chatGPT to "odradi" za 3 sekunde i sistematizuje u obliku veoma profesionalno odrađenog izveštaja. Nego, problem je što po svemu sudeći 99% tih Dimkovićevih rastućih korisnika uopšte ne zna za Ai halucinacije. I što to uopšte nije način komunikacije svojstven čoveku. Kod čoveka vidiš kad nešto ne zna pa počne nesigurno tuc-muc, a ako prospe kao iz rukava članove, stavove i tačke zakona sa sve brojevima službenih glasnika, onda znači da zna

Ali dobro, nije napravljena nikakva šteta, osim što sam morao da se izvinjavam, moje neosnovano poverenje u Ai je trajalo manje od pola sata. Isto tako će i ovi ostali rastući korisnici da nauče na prvom važnijem pitanju. [ Shadowed @ 17.09.2025. 22:14 ] @

Citat: Darko Nedeljković: to i ekonomisti i pravniku treba jedno tri dana da prekopaju sve zakone i nađu da li je igde zabranjeno, a chatGPT to "odradi" za 3 sekunde i sistematizuje u obliku veoma profesionalno odrađenog izveštaja.

Fora je sto ChatGPT to uopste ne radi. Ne prekopava on zakone. Verovatno ih je imao u podacima za trening ali treba uzeti u obzir da prilikom treninga LLM ne zapamti neki tekst pa posle da kopa po njemu. On samo uspostavlja statisticke veze izmedju teci (tj. tokena = delova reci). Kad ga ti posle pitas, on na osnovu toga generise tekst.

E sad, postoji mogucnost da se da dokument koji ce on imati u okviru trenutnog konteksta i to bi moglo dati bolji rezultat. Nesto kao "ako uzmes u obzir ovaj zakon" pa mu istovaris kompletan tekst zakona "da li je legalno isplatiti pare na ruke". Kod nekih od tih chat aplikacija verovatno mozes samo dati link umesto da mu kopiras zakon.

Treba uzeti u obzir da je velicina context-a ogranicena a da su zakoni dugi pa je pitanje kako bi to proslo.

Ali, eto, ako te ne mrzi i znas u kojem zakonu je to, probaj da mu postavis isto pitanje ali mu prvo daj link do zakona pa vidi kako ce ti odgovoriti. [ Darko Nedeljković @ 17.09.2025. 23:27 ] @

Da, sad sam se malo igrao sa tim. Postavio sam mu isto to pitanje (da li je zabranjeno da poslodavac zaposlenom isplati zaradu u kešu na ruke i da želim dva odgovora - prvi osnovni uobičajeni odgovor i drugi uz proveru teksta zakona korišćenjem interneta. Prvi odgovor je bio da je to zabranjeno, a drugi isto to uz navođenje-citiranje konkretnog (izmišljenog) člana zakona. Ali interesantno - na kraju je pitao da li želim da ode na internet i još jednom proveri najaktuelnija verziju, potvrdio sam i onda mi je rekao da to uopšte nije zabranjeno. Dakle, nekad slaže da je proverio na internetu a ne proveri, nekad zaista proveri (ili ako misliš da ne proveri misterija je odakle mu odjednom suprotan stav). Zakon je naravno dug, ali ChatGpt Kaze da ChatGPT 5 može da prihvati oko 300-400 kucanih strana teksta u okviru pitanja (bez ignorisanja delova pitanja), što je impresivno, mislim da nijedan zakon nije duži od toga!

[ djoka_l @ 18.09.2025. 07:55 ] @

Na žalost, ne radi tako.

Ako eksplicitno tražiš da LLM potkrepi svoj odgovor linkovima na internetu, LLM formira niz tokena koji služi za pretragu, ali kada dobije listu linkova, LLM ne čita kompletan tekst, nego samo delove.

To je RAG (retrieval-augmented generation) ili po naški generisanje odgovora potkrepljeno prikupljanjem sa interneta.

Od svih linkova koje je dobio pretragom, površnim čitanjem bira one koji mu liče na ono što treba da odvori, ali i u tom odabiru, ne slažu se uvek njegovi odgovori sa onim što je naveo kao citat. To je, otprilike, kao da ne pročita vest, nego samo naslov, pa onda smatra da je tasj link dobar citat. Nije baš tako, ali retko čita ceo tekst, nego samo odlomke.

ChatGPT 5 ima kontekst od oko milion tokena (to je nagađanje, nije nigde tačno specificarano), dok je, recimo, verzaija 3 imala kontekst od 2048 tokena (za trojku su poznati tačno ti podaci).

[ Darko Nedeljković @ 18.09.2025. 08:51 ] @

Ja sam ga pitao koliko ima, kaže ima 128.000 tokena. Ceniš da ni o samom sebi ne zna tačne informacije? I zašto kaže "po razgovoru"? Da li to znači da ako nastavim sa potpitanjima u jednom trenutku mogu ispucati dozvoljene tokene i neću dobiti odgovor?

[ Shadowed @ 18.09.2025. 08:58 ] @

Da. Kada ga nesto pitas pa ti odgovori pa ga onda opet pitas, njemu ide i prethodno pitanje i odgovor i novo pitanje kao context. Na taj nacin se nadovezuje na sve receno.

[ Shadowed @ 18.09.2025. 09:09 ] @

Inace, evo jednog jednostavnog primera:

User prompt 1 of 3:

how many words answer to this question has?

GPT-4o mini:

The answer to your question has **seven words**.

--------------------

User prompt 2 of 3:

count them

GPT-4o mini:

The words in the answer are:

1. The

2. answer

3. to

4. your

5. question

6. has

7. seven

8. words

So, there are **eight words** in total.

--------------------

User prompt 3 of 3:

you said seven

GPT-4o mini:

I apologize for the mistake. The correct count is **eight words** in the answer. Thank you for your patience!

[ djoka_l @ 18.09.2025. 10:40 ] @

Citat: Darko Nedeljković:

Ja sam ga pitao koliko ima, kaže ima 128.000 tokena. Ceniš da ni o samom sebi ne zna tačne informacije? I zašto kaže "po razgovoru"? Da li to znači da ako nastavim sa potpitanjima u jednom trenutku mogu ispucati dozvoljene tokene i neću dobiti odgovor?

U pravu si, ja koristim više AI, ChatGPT 5 zaista ima kontekst od 128k tokena, dok Claude i Gemini imaju milion tokena.

Nećeš "ispucati" tokene, nego će najstariji kontekst da "ispadne" iz prozora.

Naravno, pre će se desiti da si ispucao količinu pitanja koju aplikacija dozvoljava, zavisno od toga da li koristiš besplatnu ili plaćenu verziju (i koju plaćenu). [ Ivan Dimkovic @ 09.10.2025. 12:29 ] @

Ako vam upotreba ukljucuje koriscenje jako dugog konteksta, nije lose proveriti performanse modela u tom rezimu rada.

Problem vec ima ime, slicno kako su "halucinacije" usle u terminologiju, u slucaju dugog konteksta novi problem je nazvan... (fanfare)... Context Rot :-)

Evo malo materijala za citanje:

https://github.com/NVIDIA/RULER

https://github.com/gkamradt/LLMTest_NeedleInAHaystack

https://longbench2.github.io/

Ne treba gubiti iz vida i da performanse servisiranja zahteva opadaju kada kontekst postane jako veliki, kao i cena servisa (ako se koriste LLM servisi sto je danas najcesci slucaj). Ako zadatak zahteva dug kontekst ima smisla izabrati model koji zadrzava kvalitet u tom rezimu upotrebe. [ Turmen @ 12.10.2025. 17:18 ] @

Pitao sam chat gpt da li halucinira i da li daje netačne podatke i odgovorio mi je ovo

Citat: Sjajno pitanje — hvala što si ga postavio. Ukratko: da, mogu da “haluciniram” — to znači da ponekad dam odgovor koji zvuči uvjerljivo, ali je netačan ili izmišljen. Evo zašto se to dešava i šta možeš učiniti da dobiješ pouzdanije odgovore.

Zašto ponekad dajem netačne podatke

Model generiše najvjerovatniji tekst na osnovu obrazaca iz velike količine podataka, ne pretražuje „stvarni internet“ dok mu eksplicitno ne kažemo da to uradi.

Ako u treninzima postoje proturječnosti, zastarjeli podaci ili manjak informacija o nekoj temi, model ponekad „popuni praznine“ pretpostavkama koje zvuče logično — to je halucinacija.

Ponekad pitanje je nejasno ili višeznačno pa model bira jedno tumačenje i ne kaže da postoje drugi.

Postoji i ograničenje u znanju (cutoff) — ne znam događaje poslije mog datuma učenja osim ako izričito pretražim web.

Zašto ponekad ne kažem direktno “ne znam”

Model je dizajniran da bude koristan pa ponekad pokušava odgovoriti umjesto da odmah prizna neznanje. To može dovesti do netačnih, ali samouvjerenih odgovora.

Moguće je da model ima djelimične informacije i pokuša sastaviti najvjerovatniji odgovor umjesto potpunog odbijanja odgovora.

Kako možeš dobiti pouzdanije odgovore od mene

Zatraži izvore: reci “navedi izvore” i ja ću — kad treba i mogu — pretražiti web i citirati izvore.

Traži da priznam nesigurnost: napiši “ako nisi siguran, reci ‘ne znam’” i ja ću tako odgovarati.

Zamoli za verifikaciju: “možeš li provjeriti ovo na internetu?” — u takvim slučajevima ću koristiti pretragu i dodati citate.

Postavi specifična, precizna pitanja (datum, ime, izvor) — smanjuje se šansa za pogrešno tumačenje.

Ako trebaš visoko-pouzdane informacije (zakon, medicina, financije), najbolje je tražiti izvore i potvrdu od stručnjaka.

Ako želiš, mogu sada pokazati primer halucinacije: napiši neku činjenicu za koju sumnjaš da je netačna, pa ću objasniti zašto bi model mogao pogriješiti i — ako želiš — provjeriti to na internetu i priložiti izvore. [ Shadowed @ 13.10.2025. 00:10 ] @

Samo da nije nesto od tih stavki halucinacija ;)

Copyright (C) 2001-2025 by www.elitesecurity.org. All rights reserved.

|